2015-06-24 Wed

■ #2249. 綴字の余剰性 [spelling][orthography][cgi][web_service][redundancy][information_theory][punctuation][shortening][alphabet][q]

言語の余剰性 (redundancy) や費用の問題について,「#1089. 情報理論と言語の余剰性」 ([2012-04-20-1]),「#1090. 言語の余剰性」 ([2012-04-21-1]),「#1091. 言語の余剰性,頻度,費用」 ([2012-04-22-1]),「#1098. 情報理論が言語学に与えてくれる示唆を2点」 ([2012-04-29-1]),「#1101. Zipf's law」 ([2012-05-02-1]) などで議論してきた.言語体系を全体としてみた場合の余剰性のほかに,例えば英語の綴字という局所的な体系における余剰性を考えることもできる.「#1599. Qantas の発音」 ([2013-09-12-1]) で少しく論じた通り,例えば <q> の後には <u> が現われることが非常に高い確立で期待されるため,<qu> は余剰性の極めて高い文字連鎖ということができる.

英語の綴字体系は全体としてみても余剰性が高い.そのため,英語の語彙,形態,統語,語用などに関する理論上,運用上の知識が豊富であれば,必ずしも正書法通りに綴られていなくとも,十分に文章を読解することができる.個々の単語の綴字の規範からの逸脱はもとより,大文字・小文字の区別をなくしたり,分かち書きその他の句読法を省略しても,可読性は多少落ちるものの,およそ解読することは可能だろう.一般に言語の変化や変異において形式上の短縮 (shortening) が日常茶飯事であることを考えれば,非標準的な書き言葉においても,綴字における短縮が頻繁に生じるだろうことは容易に想像される.情報理論の観点からは,可読性の確保と費用の最小化は常に対立しあう関係にあり,両者の力がいずれかに偏りすぎないような形で,綴字体系もバランスを維持しているものと考えられる.

いずれか一方に力が偏りすぎると体系として機能しなくなるものの,多少の偏りにとどまる限りは,なんとか用を足すものである.主として携帯機器用に提供されている最近の Short Messages Service (SMS) では,使用者は,字数の制約をクリアするために,メッセージを解読可能な範囲内でなるべく圧縮する必要に迫られる.英語のメッセージについていえば,綴字の余剰性を最小にするような文字列処理プログラムにかけることによって,実際に相当の圧縮率を得ることができる.電信文体の現代版といったところか.

実際に,それを体験してみよう.以下の "Text Squeezer" は,母音削除を主たる方針とするメッセージ圧縮プログラムの1つである(Perl モジュール Lingua::EN::Squeeze を使用).入力するテキストにもよるが,10%以上の圧縮率を得られる.出力テキストは,確かに可読性は落ちるが,慣れてくるとそれなりの用を足すことがわかる.適当な量の正書法で書かれた英文を放り込んで,英語正書法がいかに余剰であるかを確かめてもらいたい.

2015-04-15 Wed

■ #2179. IPA の肺気流による子音の分類 (2) [phonetics][consonant][ipa][chart][hel_education][cgi][web_service]

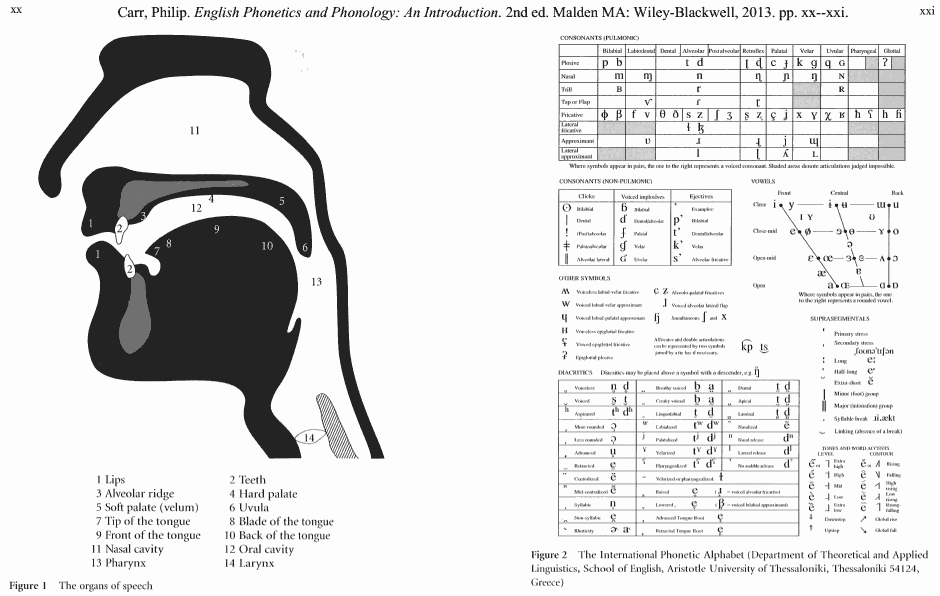

「#1813. IPA の肺気流による子音の分類」 ([2014-04-14-1]) に引き続き,調音音声学に関する図表について.Carr (xx--xxi) の音声学の教科書に,調音器官の図とIPAの分節音の表が見開きページに印刷されているものを見つけたので,スキャンした(画像をクリックするとPDFが得られる).

特に右上にある肺気流による子音の分類表について,学習の一助になるようにと,表の穴埋め問題生成ツールを以下に作ってみた.調音音声学の学習の一助にどうぞ.

・ Carr, Philip. English Phonetics and Phonology: An Introduction. 2nd ed. Malden MA: Wiley-Blackwell, 2013.

[ 固定リンク | 印刷用ページ ]

2015-01-22 Thu

■ #2096. SUBTLEX-US Word Frequency List [frequency][statistics][corpus][lexicology][zipfs_law][cgi][web_service]

従来の英語学研究において,権威ある語彙頻度表といえばアメリカ英語に関する Kucera and Francis (1967) のものや,イギリス英語に比重を置いたより新しいものとして CELEX (1993) やその2版 (cf. 「#1424. CELEX2」 ([2013-03-21-1])) がよく用いられてきた.しかし,最近,これらを批判し,新しい手法に基づいたアメリカ英語の語彙頻度表が現われた.ベルギー,ヘント大学の実験心理学科の提供する SUBTLEXus である.左のHPから,SUBTLEXus の一群の頻度表のファイルや記述がダウンドーロできる.

SUBTLEXus の基盤にあるコーパスは,8388件の映画の字幕の集成であり,総語数は5100万語に及ぶ.SUBTLEXus の頻度表は,Kucera and Francis や CELEX の頻度表と比べて,いくつかの算出された指標においてすぐれていると主張されている.頻度は,見出し語 (lemma) ごとではなく語形 (word form) ごとに数えられており,例えば名詞であれば単数形と -s 語尾などをもつ複数形は別扱いされる(異なる語形は74,286種類).名詞と動詞など複数の品詞として用いられる語形については,それぞれの品詞ごとの頻度にもアクセスできるし,より優勢な品詞 (Dominant POS) のほうへ合算した頻度へもアクセスできる.データには,ほかに何件の映画に現われているか,小文字として現われているのは何回か,頻度の対数を取った指標,Zipf 指標 (cf. 「#1101. Zipf's law」 ([2012-05-02-1])) なども含まれている.これだけの種類のデータが含まれていると,目的とアイデア次第でおおいに有効に利用できるだろう.話し言葉ベースであることも顕著な特徴だ.

ダウンロードできるいくつかのデータのなかで "a zipped Excel file of SUBTLEX-US with the Zipf values included" をダウンロードし,少しいじってみた.例えば,(1) 全体的に多く現われ,かつ (2) 多くの映画にも現われる語形は,総合的な意味で頻度が高いと考えられるだろう.そこで (1) と (2) に関する対数の指標を掛け合わせて,それを降順に並べて最初の100語を取ると,正真正銘の最頻単語100語が得られるはずだ.省略形の片割れなども含まれているが,以下がそのリストである.

you, I, the, to, s, a, it, t, that, and, of, what, in, me, is, we, this, he, on, for, my, m, your, don, have, do, re, no, be, know, was, not, can, are, all, with, just, get, here, but, there, ll, so, they, like, right, out, go, up, about, she, if, him, got, at, now, come, oh, one, how, well, want, yeah, her, think, good, see, let, did, why, who, as, going, his, will, from, when, back, time, yes, look, d, take, an, where, man, would, them, been, some, or, tell, us, had, were, say, could, gonna, didn, hey

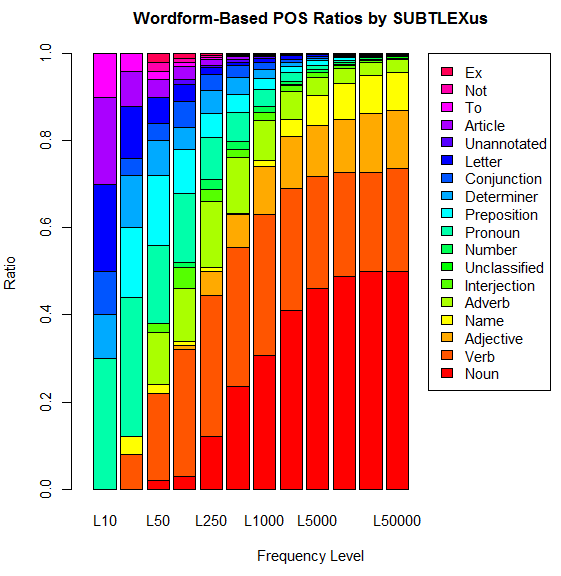

ほかには,最頻10語,25語,50語,100語,250語,500語,1,000語,2,500語,5,000語,10,000語,25,000語,50,000語,100,000語について,Dominant POS ごとに数え上げてみることもたやすい.「#666. COCA 最頻5000語で品詞別の割合は?」 ([2011-02-22-1]),「#667. COCA 最頻50万語で品詞別の割合は?」 ([2011-02-23-1]),「#1132. 英単語の品詞別の割合」 ([2012-06-02-1]) の記事でも,別のコーパスにより似たような調査を行ったが,SUBTLEX-US 版の調査結果は次のグラフにまとめられる.

以下はおまけの検索ツール (SUBTLEX-US Word Frequency Extractor) .おまけなので,10例までしか結果が出力されない仕様です.SUBTLEXus の提供する複雑な検索も可能な,SUBTLEXus Online Search もどうぞ.

2014-09-11 Thu

■ #1963. 構文文法 [bnc][construction_grammar][syntax][cognitive_linguistics][prototype][web_service][speech_act][generative_grammar]

構文文法 (construction grammar) は,この四半世紀の間で発展してきた認知言語学に基づく文法理論である.Lakoff, Fillmore, Goldberg, Kay などによって洗練されてきた.

構文という捉え方そのものは,統語論において長い伝統がある.構造言語学では当然視されていたし,その流れを汲んだ「文型」の考え方も,語学教育を通じて広く知られている.しかし,生成文法の登場により,従来の構文や文型は相対化され,二次的な付帯現象として扱われるようになった.

しかし,1970年代後半の認知言語学の誕生により,構文は単に形式的な観点からだけではなく,機能的・意味的な観点からアプローチされるようになった.特定の構文は,深層構造から生成されるのではなく,それ自身の資格において特定の意味に直接貢献する単位であるという考え方だ.例えば,Me write a novel?! という一見すると破格的な構文は,それ自体が独自の韻律(主部と述部が上昇調のイントネーションを帯びる)を伴い,「あざけり」を含意する.また,There's the bell! のような構文は,人差し指を上げる動作とともに用いられることが多く,「知覚の直示性」を表わす,といった具合だ.構文文法では,構文そのものが意味,語用,韻律などを規定していると捉える.

ただし,構文が意味などを規定しているといっても,その規定の強さは変異する.例えば,Is A B? の構文は典型的に質問の発話行為を表わすが,Is that a fact? は,通常,質問ではなく話者の驚きを表わす(いわゆる間接的発話行為 (indirect speech_act)) .このように,構文文法は,構文とその意味の関係もプロトタイプ的に考える必要があると主張する.また,定型構文となると,そのなかの語句を他のものに交換できなくなるなど,意味的,統語的に融通のきかなくなるケースもある.例えば,Thanks a lot, Thanks a million からの発展で Thanks a billion は可能だが,*Thanks a hundred は不可能となる.day in day out, month in month out は可だが,minute in minute out や century in century out は不可である,等々 (Taylor 225--28) .

構文文法は上記のように生成文法へのリアクションとして生じてきたが,近年では生成文法の側でも構文文法と親和性のある反語彙論や分散形態論などの理論が発展してきている.構文復権の徴候が顕著になってきたといえるだろう.

構文文法の枠組みで BNC の例文に構文情報を付したデータベースが,http://framenet.icsi.berkeley.edu/ で公開されており,こちらのインターフェースよりアクセスできる.数十の注目すべき英語構文が登録されている.

・ Taylor, John R. Linguistic Categorization. 3rd ed. Oxford: OUP, 2003.

2014-04-20 Sun

■ #1819. AHD Word History Note Search [etymology][dictionary][cgi][web_service]

「#1809. American Heritage Dictionary の Notes」 ([2014-04-10-1]) で,The Free Dictionary 上でアクセスできる Notes へのリンク集を作った(Notes 集そのものは,1.6MBあるこちらのページへ).今回は,そのなかから Word Histories に関する Notes を集めたものをデータベース化し,「#952. Etymology Search」 ([2011-12-05-1]) の要領で,検索ツール "AHD Word History Note Search" を作ってみた.

語源記事が登録されている見出し語を検索するだけであれば,上のリンク集で単語を検索すればよく,このツールの有用性はあまりない.このツールの特徴は,Notes の中身を正規表現で検索できる仕様(デフォルト)にある.例えば,日本に何らかの言及のある英単語の語源コラムを得たいのであれば,下の検索ボックスに Japan と入れればよいし,アイルランド関係であれば (Irish|Ireland) などだ.ほかには,search range を "Search for entry words" に入れ替えて,^[A-Z] と検索ボックスに入れると,固有名詞の語源コラムを集められる,等々.

2014-04-09 Wed

■ #1808. ARCHER 検索結果の時代×ジャンル仕分けツール (ARCHER Period-Genre Sorter) [cgi][web_service][corpus][archer][mode]

この2日間の記事「#1806. ARCHER で shew と show」 ([2014-04-07-1]) と「#1807. ARCHER で between と betwixt」 ([2014-04-08-1]) で,ARCHER の Untagged 版 を用いて,語の変異形の頻度が通時的にどのように推移してきたかを調査した.

近代英語の初期から後期を含むコーパスとしては,ほかに CEECS (The Corpus of Early English Correspondence, LC (The Lampeter Corpus of Early Modern English Tracts), CLMET3.0 (The Corpus of Late Modern English Texts, version 3.0), PPCMBE, COHA などがあり,それぞれに特徴があるが,ARCHER は,1600--1999年というまとまった期間をカバーし,英米変種それぞれについてジャンル分けがなされており,比較的大型の歴史コーパスとして価値が高い.しかし,「#1802. ARCHER 3.2」 ([2014-04-03-1]) で紹介した通り,現在ウェブ上で一般公開されている版については,いまだタグ検索などが実装されておらず,可能性を最大限に利用することはできない.しかし,工夫次第でいろいろと活用できる.実装されている Frequency lists や Keywords の機能はアイディア次第で有効に使えそうだし,コーパス全体の単語頻度リスト (TXT)も公開されている.

通時的な言語変化という観点から ARCHER に望む機能は,この2日間の記事で調査したように,ある検索語の頻度が時期を追って(ついでにジャンル別に)どのように推移してきたかを,簡単に確認できるようにすることだ.Restricted query で時期とジャンルを絞り,検索欄に検索語を入力してヒット数を数えてゆくということは手作業でできるが,時間がかかるし面倒だ.「#607. Google Books Ngram Viewer」 ([2010-12-25-1]) や COHA では,この通時的な一覧を可能にする機能が実装されているので,ARCHER でも余計に同様の機能が欲しくなる.そこで,欲しいのならば作ってしまおうということで,簡単なスクリプトを組んだ.ARCHER の検索結果のコンコーダンス・ラインには,テキストを表わすファイル名が付されているが,ファイル名の仕様によれば,末尾3文字がそれぞれジャンル,時期,英米変種のいずれかを表わす記号となっている.そこで,検索結果をコピーして,以下のテキストボックスに貼り付けてやると,適切にファイル名を解析し,時期,ジャンル,変種ごとにヒット数を整理してくれ,グラフ化してくれるというツール (ARCHER Period-Genre Sorter) を作成した.ARCHER での出力結果が数ページにまたがる場合には,少し手数がかかるが,各ページをコピペして累積していけばよい.

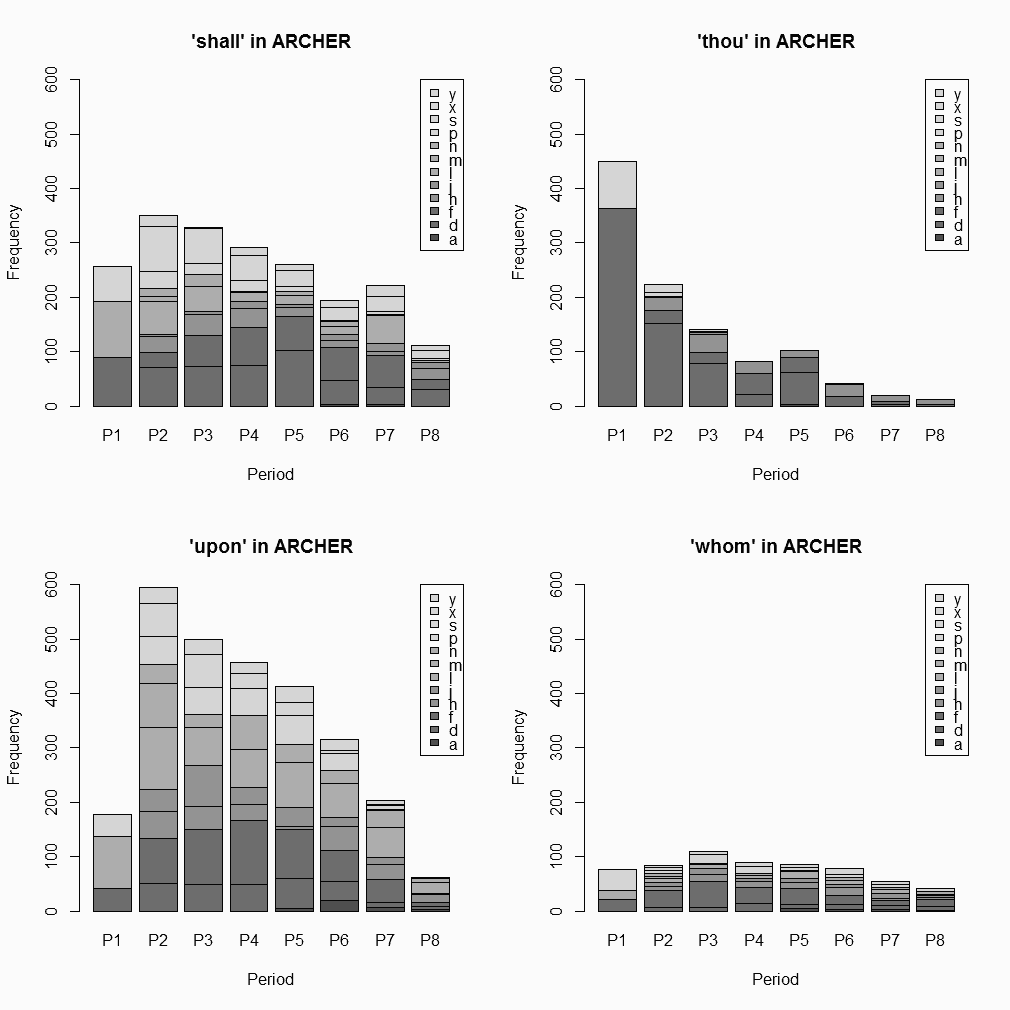

このツールの使用の応用例として,ここ数世紀の間で使用頻度が衰退しただろうと疑われる4語,shall, thou (= thou, thy, thee, thine), upon, whom を取り上げる.今回は,イギリス英語のサブコーパスのみに限定した.以下は,ツールが返した集計表をもとにグラフ化したものである.(ツールがどのように機能するかを確認するために,試しに ARCHER による 'thou' の出力結果のテキストファイル (194KB) の内容を上のテキストボックスにコピペされたい.)

2014-04-06 Sun

■ #1805. Morse code [semiotics][sign][double_articulation][cgi][web_service][morse_code]

標題は,アメリカの画家・発明家 Samuel Finley Breese Morse (1791--1872) が発明した電信用の符合.トン・ツーとも称される.短点 (dot),その3倍の長さからなる長点 (dash),空白 (space) の組み合わせからなり,その組み合わせがアルファベットや数字に対応する.

Morse は,1830年代に電信符号の着想を得て,1838年に後のモールス符号の原型を築いた.その後,1844年に Baltimore から Washington への最初の電信を開通させ,歴史的な最初のメッセージ "What has God wrought!" を送信した.彼の発明は世界的な反響を呼び,その後,ヨーロッパで改訂が加えられ,1851年に国際会議により International (or Continental) Morse Code が制定された.1938年に小さな変更が加えられたが,現在に至るまで国際的には国際版が原則として用いられている(ただし,アメリカはオリジナル版の使用にこだわり続けた).モールス符号による電信は,電話やラジオの発明により世界的に影が薄くなったが,劣悪な通信環境でも最低限の情報交換が可能であることから,21世紀の現在でも完全に無用となったわけではない.別途,和文モールス符合などの言語別変種も現れたが,現在ではアマチュア無線家による利用などに使用範囲が限られている.

記号論的には,モールス符号はいくつかの特徴をもった記号体系である.最たる特徴は,言語,とりわけ文字言語に大きく依存した記号体系であるということだろう.自立した記号体系というよりは,言語の代用記号といってよく,その点では点字や手旗信号やタムタムの太鼓言語と同様である.Saussure や「#1074. Hjelmslev の言理学」 ([2012-04-05-1]) の用語でいえば,実質 (substance) が変わっただけで,形相 (form) は変わっていないということになる.モールス符号では,あるトン・ツーの組み合わせが,アルファベット1文字に厳密に対応しており,それがもとの文字列と同じ順序で時間上あるいは空間上に配列される.そこに並び順という統辞論はあるにはあるが,それは自立した固有の統辞論ではなく,背後にある文字言語の統辞論をなぞったものにすぎない(池上,p. 125).

モールス符号のもう1つの特徴は,言語の写しであるとはいいつつも,言語とは異なる二重分節 (double_articulation) をもっていることだ.言語のように二重分節を有する記号体系というのは珍しいが,モールス符号は人工的な記号体系であるから,そこに二重分節の経済性が意図的に組み込まれたということは驚くべきことではないだろう(二重分節をもつほかの記号体系として,遺伝子の情報伝達,楽譜,電話番号などもある).しかし,言語とは異なる形で二重分節が組み込まれていることは注目に値する.モールス符号では,言語の音素に相当するものはトンとツーの2種類である.この2種類の「音素」を決まった順序で決まった個数組み合わせることで,1つの文字に対応する「形態素」を作りだし,そのような「形態素」を上記の言語依存の統辞論に則って配列してゆくのだ(池上,p. 87).ほかには,コードの規程が強い,余剰性が低いなどの特徴も挙げられよう.

では,国際モールス符号の実際をみてみよう.規約の詳細は,Recommendation ITU-R M.1677-1 (10/2009) International Morse code (PDF) より確認できる.一般の(英文)テキストと国際モールス符合の変換器は,ウェブ上に Morse Code Translator などいろいろなものがあるが,以下に hellog 版を作ってみた.テキストあるいはモールス符号を入力すると,他方へ変換される仕様.

例えば,What has God wrought! を入力すると,.-- .... .- - .... .- ... --. --- -.. .-- .-. --- ..- --. .... - -.-.-- が得られる.そして,... --- ... と入力すると,SOS が返される.なお,SOS はモールス符号として打ちやすく聞きやすい文字を並べたものであり,それ自体に意味があるものではない.

・ ピエール・ギロー 著,佐藤 信夫 訳 『記号学』 白水社〈文庫クセジュ〉,1972年.

・ 池上 嘉彦 『記号論への招待』 岩波書店〈岩波新書〉,1984年.

2014-02-03 Mon

■ #1743. ICE Frequency Comparer [corpus][web_service][cgi][frequency][new_englishes][variety][ice]

「#1730. AmE-BrE 2006 Frequency Comparer」 ([2014-01-21-1]), 「#1739. AmE-BrE Diachronic Frequency Comparer」 ([2014-01-30-1]) で,the Brown family of corpora ([2010-06-29-1]の記事「#428. The Brown family of corpora の利用上の注意」を参照)を利用した,変種間あるいは通時的な頻度比較ツールを作った.Brown family といえば,似たような設計で編まれた ICE (International Corpus of English) も想起される([2010-09-26-1]の記事「#517. ICE 提供の7種類の地域変種コーパス」を参照).1990年以降の書き言葉と話し言葉が納められた100万語規模のコーパス群で,互いに比較可能となるように作られている.

そこで,手元にある ICE シリーズのうち,Canada, Jamaica, India, Singapore, the Philippines, Hong Kong の英語変種コーパス計6種を対象に,前と同じように頻度表を作り,データベース化し,頻度比較が可能となるツールを作成した.使い方については,「#1730. AmE-BrE 2006 Frequency Comparer」 ([2014-01-21-1]) を参照されたい.

どんな使い道があるかは,アイデア次第だが.例えば,"^snow(s|ed|ing)?$", "^Japan(ese)?$", "^bananas?$", "^Asia(n?)s?$" などで検索してみるとおもしろいかもしれない.

2014-01-30 Thu

■ #1739. AmE-BrE Diachronic Frequency Comparer [corpus][ame_bre][web_service][cgi][frequency][representativeness]

「#1730. AmE-BrE 2006 Frequency Comparer」 ([2014-01-21-1]) で,2006年前後の書き言葉テキストを編纂した英米各変種コーパスを紹介し,それに基づいた頻度比較ツールを作成・公開した.そのツールを作成しながら気づいたのだが,同じ方法で編纂され,規模も同じく100万語程度の the Brown family of corpora (「#428. The Brown family of corpora の利用上の注意」 ([2010-06-29-1]))と連携させれば,直近50年間ほどの通時的な英米間頻度比較が容易に可能となる.

そこで,前の記事で紹介した Professor Paul Baker - Linguistics and English Language at Lancaster University による AmE06 と BrE06 に加えて,書き言葉アメリカ英語を代表する Brown (1961), Frown (1992),書き言葉イギリス英語を代表する LOB (1961), FLOB (1991) より語形頻度表を抽出し,合わせてデータベース化した.利用の仕方は,AmE-BrE 2006 Frequency Comparer とほぼ同じなので,そちらの取説 ([2014-01-21-1]) を参照されたい.ただし,出力される表では,問題の語形が出現するテキストの数や頻度順位は省いており,純粋に約100万語当たりの頻度を表示するにとどめているので,AmE06 と BE06 について前者の情報が必要な場合には,AmE-BrE 2006 Frequency Comparer をどうぞ.

例えば,^movies?$ と入力してみると,伝統的にアメリカ英語的とされてきたこの語の分布が,過去50年ほどの間に,イギリス英語にも浸透してきている様子がわかる.

英米差の通時的な変化を調査したいのであれば,単語だけではなく語句も受けつけ,かつ規模も巨大な「#607. Google Books Ngram Viewer」 ([2010-12-25-1]) のほうが簡便だろう.しかし,今回のツールは,the Brown family of corpora をベースにしているがゆえに,(1) 均衡かつ比較可能であり,(2) 「素性」がわかっている(再現可能性が確保されている)という利点があることは指摘しておきたい.望ましいのは,小型できめ細かなコーパスと,大型で傾向を大づかみにするコーパスとを上手に連携させることだろう.

2014-01-21 Tue

■ #1730. AmE-BrE 2006 Frequency Comparer [corpus][ame_bre][web_service][cgi][frequency][spelling]

先日,Professor Paul Baker - Linguistics and English Language at Lancaster University というページを教えてもらった.Baker 氏の編纂した現代英語・米語コーパス BE06 と AmE06 の情報と,そこから抽出した単語リストが得られる.当該のコーパス自体は,ユーザIDを請求すれば,ランカスター大学の CQP (Corpus Query Processor) system よりアクセスできる.

BE06 と AmE06 は,2006年前後に出版されたイギリス変種とアメリカ変種の書き言葉均衡コーパスである.編纂方式や構成は「#428. The Brown family of corpora の利用上の注意」 ([2010-06-29-1]) で紹介した The Brown family に準じており,500テキスト×2000語の計100万語ほどの規模だ.

さて,上のページからダウンロードできる BE06 Wordlist in WordSmith 5 format と AmE06 Wordlist in WordSmith 5 format より(見出し語ではなく)語形による頻度表を抽出し,それぞれをデータベース化して,英米変種の語の頻度を比較してくれる AmE-BrE Frequency 2006 Comparer なるツールを作成してみた.

入力するのは原則としてPerl5相当の正規表現だが,カンマ,タブ,改行などで区切った(非正規表現の)単語リストも受け付ける.1つの語形のみを入力したい場合には ^ と $ で挟んで ^loves$ のようにするか,あるいは "nothing (non-regex mode only)" のラジオボックスをオンにする.

出力形式は,デフォルトではアメリカ英語コーパスにおける頻度の高い順でソートされるようになっている ("by AmE freq") が,イギリス英語コーパスの頻度順 ("by BrE freq"),語形のアルファベット順 ("alphabetically") も可能.単語リストで入力した場合に,入力したそのままの順序で出力したいときには,"nothing (non-regex mode only)" をオンにする.

いずれも100万語規模の(今となっては)小さめのコーパスなので,語形によっては十分な頻度が得られないこともあるが,簡便に英米差をチェックしたいときには便利だろう.出力結果の WORD, AME_2006, BRE_2006 の3列を切り出して,最後の行にコーパスサイズとして "total\t1000000\t1000000" と補ったうえで,Log-Likelihood Tester, Ver. 1 に放り込めば,英米差を統計的に検定することができる.

例として,「#244. 綴字の英米差のリスト」 ([2009-12-27-1]) のうち,とりわけよく知られている類の米英綴字のペアを抜き出したリストを挙げよう.以下をコピーして,上のテキストボックスに放り込み,"nothing (non-regex mode only)" を選択して実行すると,数値として米英差が実感できる.

acknowledgment, acknowledgement, aging, ageing, aluminum, aluminium, analyze, analyse, apologize, apologise, armor, armour, behavior, behaviour, center, centre, civilization, civilisation, color, colour, defense, defence, disk, disc, endeavor, endeavour, favor, favour, favorite, favourite, fiber, fibre, flavor, flavour, fulfill, fulfil, gray, grey, harbor, harbour, honor, honour, humor, humour, inquiry, enquiry, judgment, judgement, labor, labour, license, licence, liter, litre, marvelous, marvellous, mold, mould, mom, mum, neighbor, neighbour, neighborhood, neighbourhood, odor, odour, organize, organise, pajamas, pyjamas, parlor, parlour, program, programme, realize, realise, recognize, recognise, skeptic, sceptic, specter, spectre, sulfur, sulphur, theater, theatre, traveler, traveller, tumor, tumour

これまでは,語彙や綴字に関する英米差のコーパスによる比較は,「#708. Frequency Sorter CGI」 ([2011-04-05-1]) を用いたり,「BNC Frequency Extractor」 ([2012-12-08-1]) と「#1322. ANC Frequency Extractor」 ([2012-12-09-1]) を組み合わせたり,the Brown Family corpora を併用するなど,各変種コーパスの個別比較により対処してきたが,今回のツールにより多少便利な環境ができた.

2013-10-09 Wed

■ #1626. 現代日本語書き言葉均衡コーパス BCCWJ の各種インターフェース [web_service][corpus][link][japanese]

「#1567. 英語と日本語のオンラインコーパスをいくつか紹介」 ([2013-08-11-1]) で,現代日本語のコーパスとしてKOTONOHA 「現代日本語書き言葉均衡コーパス」に言及した.この『現代日本語書き言葉均衡コーパス』 (BCCWJ: Balanced Corpus of Contemporary Written Japanese) は,大学共同利用機関法人人間文化研究機構国立国語研究所と文部科学省科学研究費特定領域研究「日本語コーパス」プロジェクトが共同で開発した本格的なコーパスである.

コーパスの内容については,同サイトに「2012年3月現在,検索対象となっているのは,以下の11種のデータ,合計約1億500万語です」とある.サンプルは,1976--2008年にかけての文書で,その11のジャンルは書籍,雑誌,新聞,白書,教科書,広報紙,Yahoo!知恵袋,Yahoo!ブログ,韻文,法律,国会会議録にわたる.各テキストからは2種類のサンプルが取られており,「ひとつは長さを1000字に固定したサンプル (固定長サンプル),もうひとつは,節や章など文章の意味上のまとまりに対応した単位の全体です (可変長サンプル).これまでの調査によれば,可変長サンプルの平均長は新聞で約1000字,書籍で4000字弱です.」とある.

BCCWJ を利用する方法やインターフェースはいくつかあるが,もっとも簡便なものが,上にもリンクを張った少納言である.登録不要で,表層の文字列によるコーパスの全文検索ができる.出力は無作為の500件と制限があるが,お手軽に試すことができる.

一方,利用申請が必要な中納言では,同コーパスに対して,短単位・長単位・文字列の3つの方法により,形態論的な複雑な検索をかけることができる.

また別のインターフェーとして,NINJAL-LWP for BCCWJ (NLB) がある.現行の1.20版では,BBCWJ のほとんどのデータを対象として,検索をかけることができる.検索ページはこちら.

関連して,NLB と同じインターフェースで利用できるもう1つの日本語コーパスを紹介する.筑波大学がウェブサイトからテキストを収集して編纂した11億語からなる筑波ウェブコーパス (Tsukuba Web Corpus: TWC) へのインターフェース,NINJAL-LWP for TWC (NLT)である.検索ページはこちら.

2013-10-05 Sat

■ #1622. eLALME [me_dialect][lalme][preposition][map][web_service]

昨日の記事「#1621. The Middle English Grammar Corpus (MEG-C)」 ([2013-10-04-1]) で触れたが,後期中英語の方言地図 LALME の改訂・電子版 eLALME が,今年,Edinburgh 大学よりオンラインで公開された.書籍版 LALME にあった誤りが訂正されるなど,改訂版といってよく,機能の豊富さや検索の便などで,今後は電子版が主として利用されてゆくことになると思われる.

書籍版に対して種々の拡張がなされているが,Item Number などの対応番号が異なっているものもあるので注意を要する.例えば,between の異形の分布について,書籍版では Dot Maps 703--06, 1118--19 に6種類の分布図が掲載されているが,電子版では Item Number 89 のもとに16種類の分布図が掲載されている.実際,Dot Map の数は電子版になって1/3以上増えた.

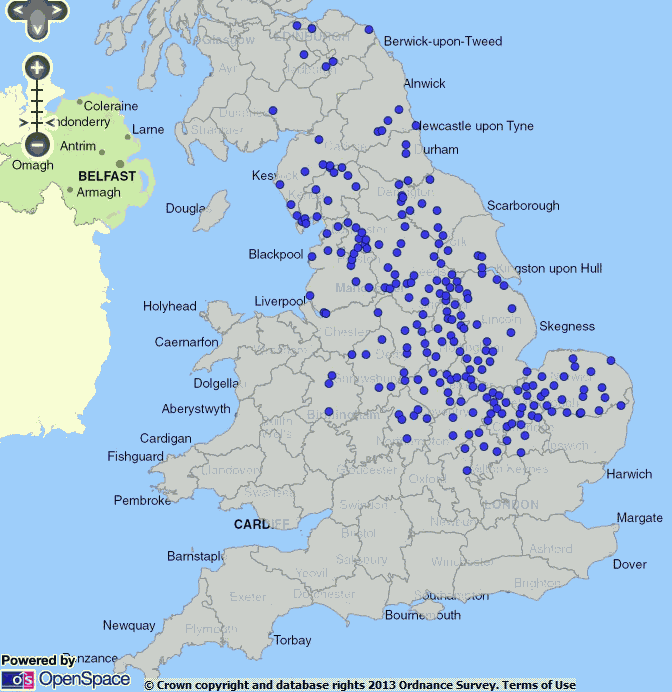

また,ユーザー定義の方言地図が描けるというのが目を見張る.「#1394. between の異形態の分布の通時的変化」 ([2013-02-19-1]) や昨日の記事 ([2013-10-04-1]) でも話題にした between の歴史的異形に関して,語末の子音群に x を含むタイプが後期中英語でどのように分布していたかを知りたい場合を想定しよう."User-defined Maps" の機能から,"Select one or more items" で "89 BETWEEN pr [North & Ireland]" を選んだ上で,"Select one or more forms" で x を含む形態のすべてにチェックを入れる.それから "Make map" をクリックすれば,以下のような Dot Map が得られるという仕組みである.既製の Dot Map よりも,条件を細かくチューニングできる.

書籍版の Item Map に相当するものは,ウェブ上での地図製作技術の限界から,電子版では得られない.しかし,代替手段として,ユーザー定義地図のドットをクリックすることにより,その地点における言語項目の異綴字をポップアップさせることができる.これは既製の Dot Map では不可能なので,ユーザー定義地図の利用価値は高い.

昨日紹介した LALME 系コーパス The Middle English Grammar Corpus (MEG-C) と合わせて,中英語方言研究もついに本格的にデジタル時代へ突入したといえるのではないか.

なお,方言地図作成といえば自作の「#846. HelMapperUK --- hellog 仕様の英国地図作成 CGI」 ([2011-08-21-1]) もどうぞ.

・ McIntosh, Angus, M. L. Samuels, and M. Benskin. A Linguistic Atlas of Late Mediaeval English. 4 vols. Aberdeen: Aberdeen UP, 1986.

2013-09-22 Sun

■ #1609. Cawdrey の辞書をデータベース化 [cawdrey][lexicography][dictionary][cgi][web_service][inkhorn_term][lexicology]

英語史上初の英英辞書 Robert Cawdrey の A Table Alphabeticall (1604) について,cawdrey の各記事で話題にしてきた.オンライン版をもとに,語彙項目記述を検索可能とするために,簡易データベースをこしらえた.半ば自動でテキストを拾ってきたものなので細部にエラーがあるかもしれないが,とりあえず使えるようにした.

データベースの内容をブラウザ上でテキスト形式にて閲覧したい方は,こちらをどうぞ(あるいはテキストファイルそのものはこちら).

以下,使用法の説明.SQL対応で,テーブル名は "cawdrey" として固定.select 文のみ有効.フィールドは7項目で,ID (整理番号),LEMMA (登録語),INITIAL (登録後の頭文字1文字),LENGTH (登録後の文字数),LANGUAGE (借用元言語),DEFINITION (定義語句),DEF_WC (定義語句の語数).典型的な検索式を例として挙げておこう.

# データベース全体を表示

select * from cawdrey

# 登録語をイニシャルにしたがってカウント

select INITIAL, count(*) from cawdrey group by INITIAL

# 登録語を文字数にしたがってカウント

select LENGTH, count(*) from cawdrey group by LENGTH

# 登録語を語源にしたがってカウント

select LANGUAGE, count(*) from cawdrey group by LANGUAGE

# 語源と語の長さの関係

select LANGUAGE, avg(LENGTH) from cawdrey group by LANGUAGE

# 登録語を定義語数にしたがってカウント

select DEF_WC, count(*) from cawdrey group by DEF_WC

# 語源と定義語数の関係

select LANGUAGE, avg(DEF_WC) from cawdrey group by LANGUAGE

# 定義に "(k)" (kind of) を含むもの

select LEMMA, DEFINITION from cawdrey where DEFINITION like '%(k)%'

# 定義に " or " を含むもの

select LEMMA, DEFINITION from cawdrey where DEFINITION like '% or %'

# 定義に " and " を含むもの

select LEMMA, DEFINITION from cawdrey where DEFINITION like '% and %'

# 定義がどんな句読点で終わっているか集計

select substr(DEFINITION, -1, 1), count(*) from cawdrey group by substr(DEFINITION, -1, 1)

・ ポール・バケ 著,森本 英夫・大泉 昭夫 訳 『英語の語彙』 白水社〈文庫クセジュ〉,1976年.

2013-08-11 Sun

■ #1567. 英語と日本語のオンラインコーパスをいくつか紹介 [web_service][corpus][efl][link][japanese]

ウェブ上で用いることのできるコーパスをいくつか紹介したい.

まず,「#1441. JACET 8000 等のベース辞書による語彙レベル分析ツール」 ([2013-04-07-1]) で取り上げた染谷泰正氏は,Business Letter Corpus のオンライン・コンコーダンサーをこちらで公開している.27種のコーパスからの検索が選択可能となっているが,メインは100万語超からなる Business Letter Corpus (BLC2000) とそれにタグ付けした POS-tagged BLC の2つだ.これは1970年代以降の英米その他の出版物から収集したデータである.

Instructions for the First-Time User でまとめられているように,種々のコーパスのなかには,167万語を超える State of the Union Address (1790--2006) などデータをダウンロードできるものもあり,有用である.英作文の学習・教育や,独自データベースのコンコーダンサー作成のために参考になる.

なお,同サイトでは,上述の各種コーパスから N-Gram Search を行なえる Bigram Plus の機能も提供している.N-Gram の検索には,本ブログより「#956. COCA N-Gram Search」 ([2011-12-09-1]) も参照.

次は,英国のリーズ大学 (University of Leeds) が作成した大規模な Leeds collection of Internet corpora.英語を始め,フランス語,日本語などの様々な言語のコーパスをオンラインで検索できる.

日本語のコーパスの情報については詳しくないが,KOTONOHA 「現代日本語書き言葉均衡コーパス」は充実しているようだ.ほかの日本語コーパスの情報源としては,コーパス日本語学のための情報館 --- コーパス紹介が有用.

2013-06-19 Wed

■ #1514. Sonority Analyser [phonetics][sonority][syllable][web_service][cgi]

昨日の記事「#1513. 聞こえ度」 ([2013-06-18-1]) で,音節を定義づけるに当たっての聞こえ度の役割を解説した.また,Sonority Sequencing Generalisation (SSG) という原則を導入し,分節音が聞こえ度の原則に従って配置されることを示した.聞こえ度の果たすこのような役割を理解し,確認するために,昨日の記事ではいくつかの単語による分析を示したが,任意の単語で分析できると便利である.

そこで,正書法にしたがって単語を入力すると,自動的にその発音を分節音へ分解し,各分節音へ sonority scale に即した聞こえ度の値を割り振り,山と谷を図示してくれるツールを作成した.以下に,"Sonority Analyser" を公開する.1つの語でもよいし,カンマ区切りで複数の語を見出し語の形で入力してもよいが,聞こえ度の山と谷の図が適切に出力される仕様である.

発音データベースには「#1159. MRC Psycholinguistic Database Search」 ([2012-06-29-1]) を用いており,たまたまそこに登録されていない語(綴字)は当然ながら出力は得られない.1つの正書法に対して複数のエントリーがある場合(同綴異義語や品詞違いなど)には,それぞれが図示される.音声表記については,MRC の原データファイルの仕様に基づいたものをそのまま使用した.

sonority scale には,原則として昨日の記事で示したものを利用しているが,(1) /w, j/ を聞こえ度8として挿入し,もともとの高母音,中母音,低母音の値は繰り上げて,それぞれ9, 10, 11とし,(2) 2重母音は下降2重母音 (falling diphthong) を前提とし,第1母音の聞こえ度の値を2重母音全体に割り当てることとした.厳密ではなくとも,プレゼンや確認の用途には十分だろう.

[ 固定リンク | 印刷用ページ ]

2013-04-07 Sun

■ #1441. JACET 8000 等のベース辞書による語彙レベル分析ツール [lexicology][web_service][link][elt]

日本の英語教育の世界では,「JACET 8000」という語彙集がよく用いられる.各語に1--8の語彙レベルが付されており,英文テキストの難易度判定や教材研究・開発などに使われる.ほかにも,類似した目的で SVL12000 や WLC などの語彙集が存在するが,それぞれの特徴については,染谷泰正氏のベース辞書についてに,次のようにある.

JACET8000 は大学英語教育学会基本語改訂委員会が編纂した学習語彙リストで,「British National Corpus と日本人英語学習者の環境を踏まえて独自に作成されたサブコーパスに準拠し,かつ中高の教育現場の状況にも配慮」して作成されたもので,「日本人英語学習者のための科学的教育語彙表」として評価を得ています.詳しくは『大学英語教育学会基本語リストJACET List of 8000 Basic Words』(大学英語教育学会基本語改訂委員会/2003年)を参照してください.

SVL12000(「標準語彙水準12000」)は株式会社アルクが独自に開発した語彙リストで,「ネイティブスピーカーの「使用頻度」をベースにしながら,日本人学習者にとっての「有用性」「重要性」を考慮して編集」したもので,既存の学習語彙表ではカバーされていない上級?最上級レベルの語彙(Level 8 ? Level 12)が含まれているのが特徴です.

WLC ベース辞書 は「AWK による語彙レベル分布計測プログラム」(染谷 1998) において作成されたもので,ビジネス英語の分析用に特化した約35,000語の見出し語からなる語彙リストです.詳しくは ここを参照してください.なお,WLC ベース辞書で使用されている品詞タグの種類についてはここを参照してください.

染谷氏の提供するオンライン版 Word Level Checker(英文語彙難易度解析プログラム)では,テキストボックスに英文を投げ込むと,語彙レベルごとのテキストカバー率を返してくれる.ベース辞書としては,JACET8000, SVL12000, WLC (Ver.02) のいずれかを選択することができる.

特に JACEL 8000 をベースとした類似ツールとしては,JACET 8000 TOOLS からいくつかのものにアクセスできる.

・ JACET 8000 LEVEL ANALYZER: 英文を投げ込むと,単語を見出し語化したうえで語彙レベルごとのテキストカバー率を返してくれる.プログラムの仕様や使用例については,清水伸一氏による JACET 8000 付属CD-ROM のプログラムデータ使用法が参考になる.

・ JACET 8000 LEVEL MARKER: 英文を投げ込むと,各単語にレベルを表わすタグ (1--8) をつけてカラー表示してくれる.

・ JACET 8000 Measuring Vocabulary: 語彙力診断テスト.「#833. 語彙力診断テスト」 ([2011-08-08-1]) で紹介した Test Your Vocab も参照.

関連して,その他の英語語彙頻度表については「#308. 現代英語の最頻英単語リスト」 ([2010-03-01-1]) を参照.

2013-03-29 Fri

■ #1432. もう1つの類義語ネットワーク「instaGrok」と連想語列挙ツール [web_service][thesaurus][synonym][cgi]

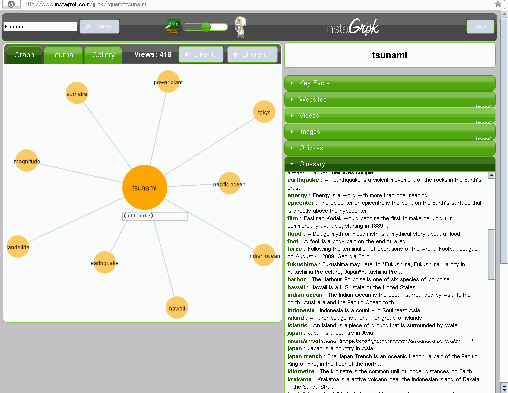

「#471. toilet の豊富な婉曲表現を WordNet と Visuwords でみる」 ([2010-08-11-1]) や「#1270. 類義語ネットワークの可視化ツールと類義語辞書」 ([2012-10-18-1]) で,オンラインで利用できるヴィジュアル類義語ツールを紹介した(特に後者[2012-10-18-1]にリンク集を作ってあるので参照).今回,新たに instaGrok なるウェブサービスを発見した.grok とは米俗語で "to understand sth completely using your feelings rather than considering the facts" を意味するが,instaGrok ではヴィジュアルで直感的に語のネットワークを把握することができる.

出力されるネットワーク図は,Graph Words, Visuwords, Visual Thesaurus などとおよそ同じだが,右欄に定義らしき例文,キーワードと結びつけられるウェブページや画像・動画へのリンク,関連する選択クイズなどが現われるのが革新的だ.さらに,右下の Glossary 欄には,指定したキーワードと連辞的 (syntagmatic) および範列的 (paradigmatic) に緩いつながりを示す類義語群(むしろ連想語群と呼ぶべきか)が簡単な説明とともに列挙されるが,これは指定キーワードを出発点とする発想支援を促すツールともなり得る.例えば,キーワードに "tsunami" を指定すると,以下のような画面が得られる(画像をクリックすると拡大版).

データソースはウェブ上のデータのようだが,内部でどのようなエンジンを使っているのかは不明である.

Glossary 欄の連想語群だけでも簡単に抜き出せると便利かもしれないと思い,次のツールを作った.並一通りの類義語辞書的な語群とは異なった連想語が得られておもしろい.ウェブベースなので,"Japan", "Pacific ocean" などの固有名詞などを入れると時事的な連想語が現われたりする.100語までのリストが出力される.

2012-12-10 Mon

■ #1323. Helsinki Corpus の COCOA 検索 [cgi][web_service][hc][corpus]

Helsinki Corpus (The Diachronic Part of the Helsinki Corpus of English Texts) は1991年に公開されて以来,英語歴史コーパスの元祖として重用されてきた.HC の役割は現在でも薄れておらず,本ブログでも「#381. oft と often の分布の通時的変化」 ([2010-05-13-1]) を始め,hc の各記事で言及してきた.

HC を本格的に使いこなすには,こちらのマニュアルを熟読する必要がある.とりわけ時代別サブコーパスの語数は押さえておく必要があるし,COCOA Format による参照コードの理解も重要だ.COCOA Format は,HC のソーステキスト内にそのテキストに関する種々の情報を付与するための形式である.各テキストについて,その年代,方言,著者の性別,韻文か散文かなどの情報が,この形式により付与されている.使用者は,この情報を利用することにより,特定の条件を満たすテキストを選び出すことができるというわけだ.

HC の COCOA 情報を利用した条件の絞り込みを簡便にするために,まず表形式にまとめ,それをデータベース化 (SQLite) した.

以下,使用法の説明.SQL対応で,テーブル名は "hccocoa" として固定.select 文のみ有効.フィールドは26項目:"ID", "A", "B", "C", "D", "E", "F", "G", "H", "I", "J", "K", "M", "N", "O", "P", "Q", "R", "S", "T", "U", "V", "W", "X", "Y", "Z".各パラメータの意味は,以下の通り.また,各パラメータの取りうる値の詳細については,マニュアルを参照(あるいは,"select distinct C from hccocoa order by C" などと検索しても調べられる).

A = "author"

B = "name of text file"

C = "part of corpus"

D = "dialect"

E = "participant relationship"

F = "foreign original"

G = "relationship to foreign original"

H = "social rank of author"

I = "setting"

J = "interaction"

K = "contemporaneity"

M = "date of manuscript"

N = "name of text"

O = "date of original"

P = "page"

Q = "text identifier"

R = "record"

S = "sample"

T = "text type"

U = "audience description"

V = "verse" or "prose"

W = "relationship to spoken language"

X = "sex of author"

Y = "age of author"

Z = "prototypical text category"

典型的な検索式を例として挙げておく.

# 表全体を再現[ 固定リンク | 印刷用ページ ]

select * from hccocoa

# 時代区分別のテキスト数

select C, count(*) from hccocoa group by C

# テキストタイプ別のテキスト数

select T, count(*) from hccocoa group by T

# ME に時代区分されているテキストの各種情報を一覧

select B, C, D, V from hccocoa where C like 'M%' order by C

2012-12-09 Sun

■ #1322. ANC Frequency Extractor [cgi][web_service][frequency][corpus][anc]

昨日の記事「#1321. BNC Frequency Extractor」 ([2012-12-08-1]) に引き続き,ANC (American National Corpus) に基づく頻度表がANC Second Release Frequency Data のページに公開されていたので,"ANC Frequency Extractor" を作成した.

仕様は,"BNC Frequency Extractor" と少々異なる.データベースは SQLite で,select 文のみ有効というのは同様.テーブルは "anc" (コーパス全体),"written" (書き言葉コーパス),"spoken" (話し言葉コーパス) ,"token" (語形ごとの頻度と生起率)の4種類.フィールドは,"anc", "written", "spoken" の各テーブルについては,"word", "lemma", "pos", "freq" の4つ,"token" のテーブルについては,"word", "freq", "ratio" の3つである.POS-tag については,Penn Treebank Tagset を参照.

以下に,検索式をいくつか挙げておこう.

# 書き言葉テキストで,英米差があるとされる "diarrhoea" vs. "diarrhea" の綴字の生起頻度を確認

select * from written where word like "diarrh%"

# 書き言葉テキストで,英米差があるとされる "judgement" vs. "judgment" の綴字の生起頻度を確認.(その他,[2009-12-27-1]の記事「#244. 綴字の英米差のリスト」の綴字を放り込んでゆくとおもしろい.)

select * from written where word like "judg%ment%"

# -ly で終わらない副詞を探す(flat adverb かもしれない例を探す)

select * from anc where lemma not like "%ly" and pos like "RB%"

# -s で終わる副詞を探す(adverbial genitive の名残かもしれない例を探す)

select * from anc where pos like "RB%" and word like "%s"

# 単数名詞と複数名詞の token 数の比較を written subcorpus と spoken subcorpus で([2011-06-07-1]の記事「#771. 名詞の単数形と複数形の頻度」を参照)

select pos, sum(freq) from written where pos in ("NN", "NNS") group by pos

select pos, sum(freq) from spoken where pos in ("NN", "NNS") group by pos

select pos, sum(freq) from anc where pos in ("NN", "NNS") group by pos

ANC は有料だが,そこから抜粋された OANC (Open American National Corpus) は無料.ANC 及び OANC については,「#708. Frequency Sorter CGI」 ([2011-04-05-1]) や「#509. Dracula に現れる whilst (2)」 ([2010-09-18-1]) を参照.

"BNC Frequency Extractor" と "ANC Frequency Extractor" を組み合わせて使えば,語彙の英米差について頻度の観点から簡単に調査できる.

2012-12-08 Sat

■ #1321. BNC Frequency Extractor [cgi][web_service][frequency][corpus][bnc]

Adam Kilgarriff が公開している BNC database and word frequency lists から,見出し語化されていない頻度表 (unlemmatised lists) をダウンロードし,検索できるようにデータベースをこしらえた.

仕様の説明.データベースには SQLite を用いており,SQL対応.select 文のみ有効.テーブルは "bnc" (コーパス全体),"written" (書き言葉コーパス),"demog" ('demographic' spoken material) ,"cg" ('context-governed' spoken material) ,"variances" (計算された分散その他の値を含む)の5種類.variances を除く4テーブルについては,フィールドは "freq" (頻度), "word" (語形), "pos" (品詞;BNC CLAWS POS-tags の一覧を参照), "files" (その語形が生起しているテキスト数)の4つ.variances のテーブルについては,上記4フィールドに加えて,"mean" (= freq / files) ,"variance" (分散),"variance_to_mean" (= variance / mean) の3つが設定されている.variances の計算基準となっているサブコーパスは,5000語以上を含む書き言葉テキストということで,全体としては約1千万語(BNC全体の約1割)である.具体的には,"select * from bnc limit 10" や "select * from variances limit 10" などとすれば,データの格納のされ方を確かめることができる.

以下に,典型的な検索式を挙げておこう.

# 書き言葉テキストで,英米差があるとされる "diarrhoea" vs. "diarrhea" の綴字の生起頻度を確認

select * from written where word like "diarrh%"

# s で始まる語形を分散の高い順に

select * from variances where word like "s%" order by variance desc limit 100

# 母音変異の複数形を示す語の単数形の頻度(cf. 「#708. Frequency Sorter CGI」([2011-04-05-1]) の例では lemma 検索だった)

select * from bnc where word in ("foot", "goose", "louse", "man", "mouse", "tooth", "woman") and pos = "nn1" order by freq desc

# 母音変異の複数形の頻度

select * from bnc where word in ("feet", "geese", "lice", "men", "mice", "teeth", "women") and pos = "nn2"

# POSでまとめて頻度の高い順に(話し言葉 'demog')

select pos, sum(freq) from demog group by pos order by sum(freq) desc

# 最も広く多く使われる名詞

select * from variances where pos like "n%" order by variance desc limit 100

# 最も広く多く使われる形容詞

select * from variances where pos like "aj%" order by variance desc limit 100

なお,見出し語化されている頻度表 (lemmatised list) については,頻度にして800回以上現われる,上位6318位までの見出し語のみに限定されており,その検索ツールは「#708. Frequency Sorter CGI」 ([2011-04-05-1]) として実装してある.関連して,「#956. COCA N-Gram Search」 ([2011-12-09-1]) も参照.

Powered by WinChalow1.0rc4 based on chalow