2013-03-29 Fri

■ #1432. もう1つの類義語ネットワーク「instaGrok」と連想語列挙ツール [web_service][thesaurus][synonym][cgi]

「#471. toilet の豊富な婉曲表現を WordNet と Visuwords でみる」 ([2010-08-11-1]) や「#1270. 類義語ネットワークの可視化ツールと類義語辞書」 ([2012-10-18-1]) で,オンラインで利用できるヴィジュアル類義語ツールを紹介した(特に後者[2012-10-18-1]にリンク集を作ってあるので参照).今回,新たに instaGrok なるウェブサービスを発見した.grok とは米俗語で "to understand sth completely using your feelings rather than considering the facts" を意味するが,instaGrok ではヴィジュアルで直感的に語のネットワークを把握することができる.

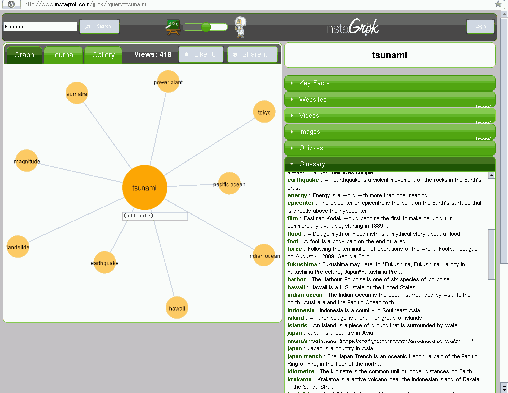

出力されるネットワーク図は,Graph Words, Visuwords, Visual Thesaurus などとおよそ同じだが,右欄に定義らしき例文,キーワードと結びつけられるウェブページや画像・動画へのリンク,関連する選択クイズなどが現われるのが革新的だ.さらに,右下の Glossary 欄には,指定したキーワードと連辞的 (syntagmatic) および範列的 (paradigmatic) に緩いつながりを示す類義語群(むしろ連想語群と呼ぶべきか)が簡単な説明とともに列挙されるが,これは指定キーワードを出発点とする発想支援を促すツールともなり得る.例えば,キーワードに "tsunami" を指定すると,以下のような画面が得られる(画像をクリックすると拡大版).

データソースはウェブ上のデータのようだが,内部でどのようなエンジンを使っているのかは不明である.

Glossary 欄の連想語群だけでも簡単に抜き出せると便利かもしれないと思い,次のツールを作った.並一通りの類義語辞書的な語群とは異なった連想語が得られておもしろい.ウェブベースなので,"Japan", "Pacific ocean" などの固有名詞などを入れると時事的な連想語が現われたりする.100語までのリストが出力される.

2013-03-22 Fri

■ #1425. 最新のアクセスランキング [notice][cgi]

「#1401. hellog で最も多くアクセスされている記事」 ([2013-02-26-1]) で示したようなアクセスランキングを定期的に更新し,どのような記事が読まれ続けているかをチェックしたいと思ったので,以下のようなアクセスランキング確認ツールをこしらえた.トップ約500件のランキング表を出力する.

・ 最新のアクセスランキング(適当なタイミングで更新してゆく予定)

・ 最新および過去のアクセスランキング一覧

3月2日現在のランキングを眺めていると,意外と最近の記事でも上位に食い込んでいるものがあり,筆者としてはありがたい.#1300 以降の記事に限ってみると,トップ100位に次の11記事が含まれていた.

- #1361. なぜ言語には男女差があるのか --- 征服説 (51)

- #1363. なぜ言語には男女差があるのか --- 女性=保守主義説 (39)

- #1397. 断続平衡モデル (39)

- #1362. なぜ言語には男女差があるのか --- タブー説 (37)

- #1401. hellog で最も多くアクセスされている記事 (32)

- #1398. 2012年の英語流行語大賞 (30)

- #1375. インターネットの使用言語トップ10 (27)

- #1379. 2012年度に提出された卒論の題目 (24)

- #1343. 英語の英米差を整理(主として発音と語彙) (21)

- #1366. 英語が非民主的な言語と呼ばれる理由 (17)

- #1383. ラテン単語を英語化する形態規則 (17)

[ 固定リンク | 印刷用ページ ]

2012-12-10 Mon

■ #1323. Helsinki Corpus の COCOA 検索 [cgi][web_service][hc][corpus]

Helsinki Corpus (The Diachronic Part of the Helsinki Corpus of English Texts) は1991年に公開されて以来,英語歴史コーパスの元祖として重用されてきた.HC の役割は現在でも薄れておらず,本ブログでも「#381. oft と often の分布の通時的変化」 ([2010-05-13-1]) を始め,hc の各記事で言及してきた.

HC を本格的に使いこなすには,こちらのマニュアルを熟読する必要がある.とりわけ時代別サブコーパスの語数は押さえておく必要があるし,COCOA Format による参照コードの理解も重要だ.COCOA Format は,HC のソーステキスト内にそのテキストに関する種々の情報を付与するための形式である.各テキストについて,その年代,方言,著者の性別,韻文か散文かなどの情報が,この形式により付与されている.使用者は,この情報を利用することにより,特定の条件を満たすテキストを選び出すことができるというわけだ.

HC の COCOA 情報を利用した条件の絞り込みを簡便にするために,まず表形式にまとめ,それをデータベース化 (SQLite) した.

以下,使用法の説明.SQL対応で,テーブル名は "hccocoa" として固定.select 文のみ有効.フィールドは26項目:"ID", "A", "B", "C", "D", "E", "F", "G", "H", "I", "J", "K", "M", "N", "O", "P", "Q", "R", "S", "T", "U", "V", "W", "X", "Y", "Z".各パラメータの意味は,以下の通り.また,各パラメータの取りうる値の詳細については,マニュアルを参照(あるいは,"select distinct C from hccocoa order by C" などと検索しても調べられる).

A = "author"

B = "name of text file"

C = "part of corpus"

D = "dialect"

E = "participant relationship"

F = "foreign original"

G = "relationship to foreign original"

H = "social rank of author"

I = "setting"

J = "interaction"

K = "contemporaneity"

M = "date of manuscript"

N = "name of text"

O = "date of original"

P = "page"

Q = "text identifier"

R = "record"

S = "sample"

T = "text type"

U = "audience description"

V = "verse" or "prose"

W = "relationship to spoken language"

X = "sex of author"

Y = "age of author"

Z = "prototypical text category"

典型的な検索式を例として挙げておく.

# 表全体を再現[ 固定リンク | 印刷用ページ ]

select * from hccocoa

# 時代区分別のテキスト数

select C, count(*) from hccocoa group by C

# テキストタイプ別のテキスト数

select T, count(*) from hccocoa group by T

# ME に時代区分されているテキストの各種情報を一覧

select B, C, D, V from hccocoa where C like 'M%' order by C

2012-12-09 Sun

■ #1322. ANC Frequency Extractor [cgi][web_service][frequency][corpus][anc]

昨日の記事「#1321. BNC Frequency Extractor」 ([2012-12-08-1]) に引き続き,ANC (American National Corpus) に基づく頻度表がANC Second Release Frequency Data のページに公開されていたので,"ANC Frequency Extractor" を作成した.

仕様は,"BNC Frequency Extractor" と少々異なる.データベースは SQLite で,select 文のみ有効というのは同様.テーブルは "anc" (コーパス全体),"written" (書き言葉コーパス),"spoken" (話し言葉コーパス) ,"token" (語形ごとの頻度と生起率)の4種類.フィールドは,"anc", "written", "spoken" の各テーブルについては,"word", "lemma", "pos", "freq" の4つ,"token" のテーブルについては,"word", "freq", "ratio" の3つである.POS-tag については,Penn Treebank Tagset を参照.

以下に,検索式をいくつか挙げておこう.

# 書き言葉テキストで,英米差があるとされる "diarrhoea" vs. "diarrhea" の綴字の生起頻度を確認

select * from written where word like "diarrh%"

# 書き言葉テキストで,英米差があるとされる "judgement" vs. "judgment" の綴字の生起頻度を確認.(その他,[2009-12-27-1]の記事「#244. 綴字の英米差のリスト」の綴字を放り込んでゆくとおもしろい.)

select * from written where word like "judg%ment%"

# -ly で終わらない副詞を探す(flat adverb かもしれない例を探す)

select * from anc where lemma not like "%ly" and pos like "RB%"

# -s で終わる副詞を探す(adverbial genitive の名残かもしれない例を探す)

select * from anc where pos like "RB%" and word like "%s"

# 単数名詞と複数名詞の token 数の比較を written subcorpus と spoken subcorpus で([2011-06-07-1]の記事「#771. 名詞の単数形と複数形の頻度」を参照)

select pos, sum(freq) from written where pos in ("NN", "NNS") group by pos

select pos, sum(freq) from spoken where pos in ("NN", "NNS") group by pos

select pos, sum(freq) from anc where pos in ("NN", "NNS") group by pos

ANC は有料だが,そこから抜粋された OANC (Open American National Corpus) は無料.ANC 及び OANC については,「#708. Frequency Sorter CGI」 ([2011-04-05-1]) や「#509. Dracula に現れる whilst (2)」 ([2010-09-18-1]) を参照.

"BNC Frequency Extractor" と "ANC Frequency Extractor" を組み合わせて使えば,語彙の英米差について頻度の観点から簡単に調査できる.

2012-12-08 Sat

■ #1321. BNC Frequency Extractor [cgi][web_service][frequency][corpus][bnc]

Adam Kilgarriff が公開している BNC database and word frequency lists から,見出し語化されていない頻度表 (unlemmatised lists) をダウンロードし,検索できるようにデータベースをこしらえた.

仕様の説明.データベースには SQLite を用いており,SQL対応.select 文のみ有効.テーブルは "bnc" (コーパス全体),"written" (書き言葉コーパス),"demog" ('demographic' spoken material) ,"cg" ('context-governed' spoken material) ,"variances" (計算された分散その他の値を含む)の5種類.variances を除く4テーブルについては,フィールドは "freq" (頻度), "word" (語形), "pos" (品詞;BNC CLAWS POS-tags の一覧を参照), "files" (その語形が生起しているテキスト数)の4つ.variances のテーブルについては,上記4フィールドに加えて,"mean" (= freq / files) ,"variance" (分散),"variance_to_mean" (= variance / mean) の3つが設定されている.variances の計算基準となっているサブコーパスは,5000語以上を含む書き言葉テキストということで,全体としては約1千万語(BNC全体の約1割)である.具体的には,"select * from bnc limit 10" や "select * from variances limit 10" などとすれば,データの格納のされ方を確かめることができる.

以下に,典型的な検索式を挙げておこう.

# 書き言葉テキストで,英米差があるとされる "diarrhoea" vs. "diarrhea" の綴字の生起頻度を確認

select * from written where word like "diarrh%"

# s で始まる語形を分散の高い順に

select * from variances where word like "s%" order by variance desc limit 100

# 母音変異の複数形を示す語の単数形の頻度(cf. 「#708. Frequency Sorter CGI」([2011-04-05-1]) の例では lemma 検索だった)

select * from bnc where word in ("foot", "goose", "louse", "man", "mouse", "tooth", "woman") and pos = "nn1" order by freq desc

# 母音変異の複数形の頻度

select * from bnc where word in ("feet", "geese", "lice", "men", "mice", "teeth", "women") and pos = "nn2"

# POSでまとめて頻度の高い順に(話し言葉 'demog')

select pos, sum(freq) from demog group by pos order by sum(freq) desc

# 最も広く多く使われる名詞

select * from variances where pos like "n%" order by variance desc limit 100

# 最も広く多く使われる形容詞

select * from variances where pos like "aj%" order by variance desc limit 100

なお,見出し語化されている頻度表 (lemmatised list) については,頻度にして800回以上現われる,上位6318位までの見出し語のみに限定されており,その検索ツールは「#708. Frequency Sorter CGI」 ([2011-04-05-1]) として実装してある.関連して,「#956. COCA N-Gram Search」 ([2011-12-09-1]) も参照.

2012-08-19 Sun

■ #1210. 中英語のフランス借用語の一覧 [french][loan_word][lexicology][me][web_service][cgi]

中英語にフランス語から借用された単語リストはどの英語史概説書にも掲載されているが,本ブログでも簡便に参照できるように一覧化ツールを作ってみた.

フランス借用語の簡易データベースを,Baugh and Cable (169--74, 177) に基づいて作成し,意味その他の基準で9個のカテゴリーに分けた (Miscellany; Fashion, Meals, and Social Life; Art, Learning, Medicine; Government and Administration; Law; Army and Navy; Christian Church; 15th-Century Literary Words; Phrases) .954個の語句からなるデータを納めたテキストファイルはこちら.ここから,カテゴリーごとに10語句をランダムに取り出したのが,以下のリストである.このリストに飽き足りなければ,

をクリックすれば,次々にランダムな一覧が生成される.「こんな語句もフランス語だったとは」と驚かせるプレゼン用途にどうぞ.

- Miscellany

- Fashion, Meals, and Social Life

- Art, Learning, Medicine

- Government and Administration

- Law

- Army and Navy

- Christian Church

- 15th-Century Literary Words

- Phrases

please, curious, scandal, approach, faggot, push, fierce, double, purify, carpenter

train, pullet, mustard, sugar, enamel, mackerel, sole, fashion, jollity, russet

pulse, color, cloister, pen, pillar, ceiling, base, lattice, cellar, sulphur

rebel, retinue, reign, duchess, allegiance, treaty, nobility, court, tax, statute

mainpernor, arson, judge, property, culpable, amerce, convict, bounds, innocent, legacy

arm, array, arms, soldier, chieftain, portcullis, havoc, brandish, stratagem, combat

incense, faith, abbey, passion, immortality, cardinal, friar, legate, virtue, convent

ingenious, appellation, destitution, harangue, prolongation, furtive, sumptuous, combustion, diversify, representation

according to, to hold one's peace, without fail, in vain, on the point of, subject to, to make believe, by heart, at large, to draw near

・ Baugh, Albert C. and Thomas Cable. A History of the English Language. 5th ed. London: Routledge, 2002.

2012-07-31 Tue

■ #1191. Pronunciation Search [pronunciation][web_service][cgi][ame][dictionary]

綴字ではなく発音で引ける(電子)辞書はいくつかあるが,ある発音をもつ語を一覧にするなどの目的には,今ひとつ使い勝手が悪い.特に,本格的なリストを作るというよりは,軽く単語例を列挙したいなどの日常的な目的には,もっと簡便に使える検索ツールが欲しい.そこで,Grady Ward's Moby からダウンロードできる Moby Pronunciator の圧縮ファイルに含まれている,無償で無制限に利用可能な発音データベース The Carnegie Mellon Pronouncing Dictionary を下敷きにした発音検索ツールを作成した.このデータベースは110935個のエントリーからなるアメリカ英語の発音辞書である(3MB以上あるデータファイルはこちら).

検索の指定は,Carnegie Mellon Pronouncing Dictionary の発音表記に対して正規表現で与えるという仕様である.発音表記の凡例は以下の通り.音素間は半角スペースで区切られている.また,強勢は母音表記に続く 0 (no stress), 1 (primary stress), 2 (secondary stress) で示される.例えば,dictionary の発音表記は,"D IH1 K SH AH0 N EH2 R IY0" などとなる.なお,発音検索は,[2012-06-29-1]の記事で公開した「#1159. MRC Psycholinguistic Database Search」の機能の1部を利用することもできる.

| Phoneme | Example | Translation |

|---|---|---|

| AA | odd | AA D |

| AE | at | AE T |

| AH | hut | HH AH T |

| AO | ought | AO T |

| AW | cow | K AW |

| AY | hide | HH AY D |

| B | be | B IY |

| CH | cheese | CH IY Z |

| D | dee | D IY |

| DH | thee | DH IY |

| EH | Ed | EH D |

| ER | hurt | HH ER T |

| EY | ate | EY T |

| F | fee | F IY |

| G | green | G R IY N |

| HH | he | HH IY |

| IH | it | IH T |

| IY | eat | IY T |

| JH | gee | JH IY |

| K | key | K IY |

| L | lee | L IY |

| M | me | M IY |

| N | knee | N IY |

| NG | ping | P IY NG |

| OW | oat | OW T |

| OY | toy | T OY |

| P | pee | P IY |

| R | read | R IY D |

| S | sea | S IY |

| SH | she | SH IY |

| T | tea | T IY |

| TH | theta | TH EY T AH |

| UH | hood | HH UH D |

| UW | two | T UW |

| V | vee | V IY |

| W | we | W IY |

| Y | yield | Y IY L D |

| Z | zee | Z IY |

| ZH | seizure | S IY ZH ER |

2012-07-18 Wed

■ #1178. MED Spelling Search [dictionary][cgi][web_service]

MED (Middle English Dictionary) が2001年にオンライン化されてから,中英語の研究環境はとてつもなく便利になった.見出し語と異綴りの検索に関しては,通常のインターフェースのほか正規表現対応インターフェースも用意されており,自由度が高い.

しかし,いずれの検索結果の出力も,見出し語とそのエントリーへのリンクが張られているだけで,異綴りの種類を一覧したい場合には不便である.それを確認するには,いちいちエントリーの本文へ飛ばなければならない.そこで,Perl5相当の正規表現に対応し,出力結果で見出し語とともに異綴りも確認できる検索ツールを作成した.綴字に注目したMED検索にどうぞ.

検索対象は,辞書の各エントリーの "headword and forms" 部分である.正規表現検索では,辞書上の母音に付された長音記号や短音記号のは無視される.<æ, Æ> は <A>, <þ, Þ, ð, ð> は <T>, <ȝ, Ȝ> は <3>, <œ> は <O> として検索文に指定できる.例として,一般の見出し語検索には "^taken\b" を,-li 副詞を一覧するには "li\b \(adv\.\)" を指定(前後の引用符は除く).

2012-06-29 Fri

■ #1159. MRC Psycholinguistic Database Search [cgi][web_service][lexicology][frequency][statistics]

昨日の記事[2012-06-28-1]で紹介した英語語彙データベース MRC Psycholinguistic Database を,本ブログ上から簡易検索するツールを作成した.実際には検索ツールというよりは,MRC Psycholinguistic Database を用いると,こんなことができるということを示すデモ版にすぎず,出力結果は10行のみに限定してある.本格的な使用には,昨日示したページからデータベースと検索プログラムをダウンロードするか,ウェブ上のインターフェース (Online search (answers limited to 5000 entries) or Online search (limited search capabilities)) よりどうぞ.

以下,使用法の説明.SQL対応で,テーブル名は "mrc2" として固定.フィールドは以下の27項目:ID, NLET, NPHON, NSYL, K_F_FREQ, K_F_NCATS, K_F_NSAMP, T_L_FREQ, BROWN_FREQ, FAM, CONC, IMAG, MEANC, MEANP, AOA, TQ2, WTYPE, PDWTYPE, ALPHSYL, STATUS, VAR, CAP, IRREG, WORD, PHON, DPHON, STRESS.各パラメータが取る値の詳細については,原データファイルの仕様を参照のこと(仕様中に示されている各種統計値はそれ自身が非常に有用).select 文のみ有効.以下に,典型的な検索式を例として載せておく.

# 文字数で語彙を分別

select NLET, count(NLET) from mrc2 group by NLET;

# 音素数で語彙を分別

select NPHON, count(NPHON) from mrc2 group by NPHON;

# 音節数で語彙を分別

select NSYL, count(NSYL) from mrc2 group by NSYL;

# -ed で終わる形容詞を頻度順に

select WORD, K_F_FREQ from mrc2 where WTYPE = 'J' and WORD like '%ed' order by K_F_FREQ desc;

# 2音節の名詞,形容詞,動詞を強勢パターンごとに分別 (「#814. 名前動後ならぬ形前動後」 ([2011-07-20-1]) 及び「#801. 名前動後の起源 (3)」 ([2011-07-07-1]) を参照)

select WTYPE, STRESS, count(*) from mrc2 where NSYL = 2 and WTYPE in ('N', 'J', 'V') group by WTYPE, STRESS;

# <gh> の綴字で終わり,/f/ の発音で終わる語

select distinct WORD, DPHON from mrc2 where WORD like '%gh' and DPHON like '%f';

# 不規則複数形を頻度順に

select WORD, K_F_FREQ from mrc2 where IRREG = 'Z' and TQ2 != 'Q' order by K_F_FREQ desc;

# 馴染み深く,具体的な意味をもつ語

select distinct WORD, FAM from mrc2 where FAM > 600 and CONC > 600;

# イメージしやすい語

select distinct WORD, IMAG from mrc2 order by IMAG desc limit 30;

# 「有意味」な語

select distinct WORD, MEANC, MEANP from mrc2 order by MEANC + MEANP desc limit 30;

# 名前動後など品詞によって強勢パターンの異なる語

select WORD, WTYPE, DPHON from mrc2 where VAR = 'O';

2012-03-19 Mon

■ #1057. LAEME Index of Sources の検索ツール Ver. 2 [laeme][web_service][cgi][dialect]

[2011-11-25-1]の記事「#942. LAEME Index of Sources の検索ツール」で SQL による検索用 CGI を公開した.最近,研究で LAEME を本格的に使う機会があり,検索用のデータベースに少しく情報を追加した.そこで,上位互換となる Ver. 2 を作ったので,公開する.

追加した情報は,PERIOD, COUNTY, DIALECT の3フィールド.PERIOD は,もともとの IOS で与えられていたテキストの DATE をもとに,半世紀区切りで大雑把に区分しなおしたもの.C13b2--C14a1 など区分のまたがる場合には,早いほうをとって C13b と読み替えた."ca. 1300" なども同様に,早いほうへ倒して C13b とした.DATE において C13, C14 など半世紀で区切れない年代が与えられている場合には,C13, C14 のようにそのまま残した.

COUNTY は,LOC に与えられていた情報をもとに,3文字の略字表記で示した.DIALECT は,所属する州 (county) をもとに大雑把に N (Northern), NWM (North-West Midland), NEM (North-East Midland), SEM (South-East Midland), SWM (South-West Midland), SW (Southwestern), SE (Southeastern) の7方言に区分したものである.方言線は州境と一致しているわけではないし,方言線そのものの選定も,「#130. 中英語の方言区分」 ([2009-09-04-1]) や「#1030. England の現代英語方言区分 (2)」 ([2012-02-21-1]) で見たように,難しい.したがって,今回の DIALECT の付与も,[2009-09-04-1]の中英語方言地図に大雑把に照らしての仮のものである.参考までに,COUNTY と DIALECT の対応表はこちら.

使用法は[2011-11-25-1]の旧版と同じで,テーブル名は "ios" (for "Index of Sources") で固定.フィールドは,全部で23フィールド (ID, MS, TEXT_ID, FILE, DATE, PERIOD, TEXT, GRID, LOC, COUNTY, DIALECT, COMMENT, SAMPLING, TAGGED_WORDS, PLACE_NAMES, PERSONAL_NAMES, WORDS, SCRIPT, OTHER, STATUS, BIBLIO, CROSS_REF, URL) .select 文のみ有効.以下,典型的な検索式を挙げておく.

# 各 PERIOD に振り分けられたテキストの数

select distinct PERIOD, count(*) from ios group by PERIOD;

# 各 COUNTY に振り分けられたテキストの数

select distinct COUNTY, count(*) from ios group by COUNTY;

# 各 DIALECT に振り分けられたテキストの数

select distinct DIALECT, count(*) from ios group by DIALECT;

# DIALECT/PERIOD ごとに,所属するテキストの多い順にリストアップ

select distinct DIALECT, PERIOD, count(*) from ios group by DIALECT, PERIOD order by count(*) desc;

# Worcestershire のテキストを取り出し,PERIOD 順に諸情報を羅列

select TEXT_ID, FILE, MS, COUNTY, PERIOD, TAGGED_WORDS from ios where COUNTY = 'WOR' order by PERIOD;

2011-12-09 Fri

■ #956. COCA N-Gram Search [cgi][web_service][coca][corpus][collocation][n-gram]

##953,954,955 の記事で,最近公開された COCA ( Corpus of Contemporary American English ) の n-gram データベースを利用してみた.COCA に現われる 2-grams, 3-grams, 4-grams, 5-grams について,それぞれ最頻約100万の表現を羅列したデータベースで,手元においておけば,工夫次第で COCA のインターフェースだけでは検索しにくい共起表現の検索が可能となる.

ただし,各 n-gram のデータベースは,数十メガバイトの容量のテキストファイルで,直接検索するには重たい.そこで,SQLite データベースへと格納し,SQL 文による検索が可能となるように検索プログラムを組んだ.以下は,検索結果の最初の10行だけを出力する CGI である.

以下,使用法の説明.テーブル名は n-gram の "n" の値に応じて,"two", "three", "four", "five" とした.ちなみに,1-grams のデータベース(事実上,COCA に3回以上現われる語の頻度つきリスト)も付随しており,こちらもテーブル名 "one" としてアクセス可能にした.フィールドは,全テーブルに共通して "freq" (頻度)があてがわれているほか,"n" の値に応じて,"word1" から "word5" までの語形 (case-sensitive) と,"pos1" から "pos5" までの COCA の語類標示タグが設定されている.select 文のみ有効.以下に,典型的な検索式を例として載せておく.

# 1-grams で,前置詞を頻度順に取り出す(ただし,case-sensitive なので再集計が必要)

select * from one where pos1 like "i%" order by freq desc;

# 2-grams で,ハンサムなものを頻度順に取り出す

select * from two where word1 = "handsome" and pos1 = "jj" and pos2 like "nn_" order by freq desc;

# 2-grams で,"absolutely (adj.)" で強調される形容詞を頻度順に取り出す([2011-03-12-1]の記事「#684. semantic prosody と文法カテゴリー」を参照)

select * from two where word1 = "absolutely" and pos2 = "jj" order by freq desc;

# 3-grams で,高頻度の as ... as 表現を取り出す

select * from three where word1 = "as" and word3 = "as" order by freq desc;

# 4-grams で,高頻度の from ... to ... 表現を取り出す

select * from four where word1 = "from" and pos1 = "ii" and word3 = "to" and pos3 = "ii" order by freq desc;

# 5-grams で,死因を探る; "die of" と "die from" の揺れを観察する

select * from five where word1 in ("die", "dies", "died", "dying") and pos1 like "vv%" and word2 in ("of", "from") and pos2 like "i%" order by word3;

n-gram データベースを最大限に使いこなすには,このようにして得られた検索結果をもとにさらに条件を絞り込んだり,複数の検索結果を付き合わせるなどの工夫が必要だろう.

2011-12-05 Mon

■ #952. Etymology Search [etymology][dictionary][cgi][web_service][metathesis][blend][dissimilation]

[2010-04-03-1]の英語語源情報ぬきだしCGIの上位互換である,[2010-04-23-1]の英語語源情報ぬきだしCGI(一括版)のさらに上位互換となる,多機能版「Etymology Search」を作成した.情報源は引き続き Online Etymology Dictionary.

今回の版で新しいのは,通常の語形による検索に加えて正規表現による検索も可能にしたこと,見出し語とは別に定義(語源解説)内の検索を可能にしたことだ.

初期設定のとおりに "non-regex" かつ "word-form" として検索すると,通常の見出し語検索となる.カンマや改行で区切られた複数の単語を指定すれば,対応する語源記述が得られる.

search mode として "regex" を指定すると,perl5 相当の正規表現(改行区切りで複数指定可)を用いた検索が可能となる.正規表現を駆使すれば,語形の一部のみにマッチさせて,多数の語を拾い出すことも可能だ.

さらに,search range に "definition (in one-line regex)" を指定すれば,定義(語源解説)内の文字列を対象として検索できる.この機能では,search mode の値にかかわらず,自動的に正規表現検索(改行区切りにより複数の正規表現を指定することは不可)となるので注意."(?i)" を正規表現の先頭に付加すれば,case-intensive の機能となる.例えば,次のような検索例は有用かもしれない.

・ 音位転換を経た(かもしれない)語を一覧

(?i)\bmetathesis

・ かばん語(かもしれない)例を一覧

(?i)\bblend(s|ed|ing|ings)\b

・ 異化を経た(かもしれない)語を一覧

(?i)\bdissimilat

・ 日本語からの借用語(かもしれない)語を一覧

(?i)\bJapanese\b

2011-11-25 Fri

■ #942. LAEME Index of Sources の検索ツール [laeme][web_service][cgi]

LAEME で Auxiliary Data Sets -> Index of Sources とメニューをたどると,LAEME が対象としているテキストソースのリスト (The LAEME Index of Sources) を,様々な角度から検索して取り出すことができる.LAEME のテキストデータベースを年代別,方言別,Grid Reference 別などの基準で分析したい場合に,適切なテキストの一覧を得られるので,LAEME 使いこなしのためには非常に重要な機能である.

しかし,もう少し検索式に小回りを利かせられたり,一覧の出力がコンパクトに表形式で得られれば使い勝手がよいだろうと思っていた.そこで,Index of Sources を独自にデータベース化し,SQL を用いて検索可能にしてみた.LAEME の使用者で,かつSQLを扱える人以外には何も役に立たないのだが,せっかく作ったので公開.

以下,使用法の説明.テーブル名は "ios" (for "Index of Sources") で固定.フィールドは,LAEME 本家の検索で対象となっている18のフィールドに加えて,整理番号としての "ID" と,テキスト情報の掲載されたオンラインページへの "URL" を加えた計20フィールド (ID, MS, TEXT_ID, FILE, DATE, TEXT, GRID, LOC, COMMENT, SAMPLING, TAGGED_WORDS, PLACE_NAMES, PERSONAL_NAMES, WORDS, SCRIPT, OTHER, STATUS, BIBLIO, CROSS_REF, URL) .select 文のみ有効.以下に,典型的な検索式を例として載せておく.

# Ancrene Wisse/Riwle のテキスト情報の取り出し

select TEXT_ID, MS, FILE, GRID, LOC, DATE, TEXT from ios where FILE like "%ar%t.tag" and TEXT like "%Ancrene%";

# Poema Morale のテキスト情報の取り出し

select TEXT_ID, MS, FILE, GRID, LOC, DATE, TEXT from ios where FILE like "%pm%t.tag" and TEXT like "%Poema%";

# Grid Reference の与えられているテキストの取り出し

select TEXT_ID, MS, FILE, GRID from ios where GRID != "000 000";

# DATE に "C13a" を含むテキストの取り出し

select TEXT_ID, DATE from ios where DATE like "%C13a%";

# 年代ごとに集計

select DATE, count(DATE) from ios group by DATE order by DATE;

# タグ付けされている語数をテキストごとに確認

select TEXT_ID, TAGGED_WORDS, PLACE_NAMES, PERSONAL_NAMES from ios;

# 全テキスト情報へのリンク集

select TEXT_ID, MS, FILE, URL from ios;

2011-08-21 Sun

■ #846. HelMapperUK --- hellog 仕様の英国地図作成 CGI [cgi][web_service][map][lalme][laeme][bre]

中英語の方言を研究していると,LALME の Dot Map 風のイングランド地図を描けると便利だと思う機会がある.LALME の地図を用いるのであればコピーしたりスキャンしたりすればよいし,オンラインの LAEME であれば "Mapping" 機能から "Feature Maps" で特に注目すべき言語項目に関する地図はデジタル画像で得られる.後者では,"Create a Feature Map" なるユーザーによる地図作成機能もおいおい追加されるとのことで,中英語方言学のヴィジュアル化は今後も進展して行くと思われる.

しかし,それでも様々な困難や不便はある.例えば,LAEME でも,自分の関心のある言語項目が LAEME 自体で扱われていなければ地図作成機能は役に立たないし(例えば,私の中英語名詞複数の研究では名詞の歴史的な文法性が重要だが,LAEME text database では性がタグ付けされていないのでフルには活用できなかった),LALME についてはそもそも地図がデジタル化されていず応用しにくい(地図のデジタル化,少なくともテキスト情報や座標情報のデジタル化が一刻も早く望まれる).

それでも,手をこまねいて待っているわけには行かない.既存のツールと自分の関心は大概ずれているものであり,自ら研究環境を作る必要に迫られるのが常だからだ.中英語の方言地図に関する限り,LALME や LAEME からテキストの方言付与情報さえ得られれば,自ら集めた言語項目に関するデータを地図上にプロットすることは十分に可能である.(需要は少ないと思われるが)その作業を少しでも簡便化するために,HelMapperUK なる CGI を作成してみた.英国のベースマップ上にデータポイントをプロットするという単機能に特化しており,凡例をつけるなどの付加機能はないが,ヴィジュアル化して概観をつかむという用途には十分と思われる.

以下で使い方の説明をするが,その前に,まずこちらのデータファイルの内容を上のテキストボックスに上書きコピペして出力結果の確認をどうぞ.これは,拙著の複数形研究で分析した初期中英語テキストの分布で,赤丸が手作業で分析したもの,青四角が LAEME text database を援用して分析したもの,それぞれの形で小さいものはテキストの全体ではなく部分を分析したものを表わす.(実際,Hotta (55) の地図はおよそこのようにして描かれた.)

では,使い方の説明(基本的に作者個人仕様のものを公開しているだけなのでインターフェースは洗練されていません,あしからず).テキストボックスにあらかじめ入力されているとおり,入力データは設定部 (Configuration) で始まる.以下が設定可能な変数.

・ 「map」変数には "England" か "UK" が入る.これで,出力される地図の範囲を決定.

・ 「scale」変数は,X方向とY方向への拡大率を指定.拡大なし (scale=1 1) だと,出力画像は 386 * 313 Pixels (England) ,529 * 557 Pixels (UK) の大きさ.

・ 「pattern + 数字」変数は,プロットに用いる記号を定義する.イコールの後にはスペース区切りで (1) 形 ("box", "circle", "cross", "diamond", "invertedtriangle", "plus", or "triangle") ,(2) その形を塗りつぶすか否か (ex. "fill" or "stroke") ,(3) 色 (ex. "aqua", "black", "blue", "cyan", "green", "lime", "magenta", "red"; 他の大抵の色名にも対応しているはずだが出力される画像に反映されない色もある) ,(4) 大きさ(線の長さや円の直径に相当する Pixels)の4項目の値を与える.パターンは好きなだけユーザー定義可能.

その後にデータ部 (Data points) が続く.1行に1データポイントで,各行はタブ区切りで (1) X座標,(2) Y座標,(3) 上で定義されたパターン名のいずれか ("pattern1" など)の3項目の値を与える(実際にはパターン名は省略可能.その場合,自動的に "pattern1" が用いられる.).座標系については,LALME や LAEME で採用されている Ordinance Survey National Grid Reference の3桁ずつの座標系 (ex. "372 244") ,あるいは一般の経度・緯度 (ex. -2.408752393 52.09322081) のいずれも可能(自動で判定される).

空行,あるいは "#" で始まるコメント行はデータとして無視される.

出力結果は GIF 形式の画像として表われる.別途,EPS 形式のベクター画像としてもダウンロードできるようにした(こちらのファイルをいじれるのであれば,各種の設定を含めた細かいチューニングが可能).

英国ベースマップの作成には,CIA World DataBank II や DCW Map Interface for Europe のデータを参照した.

(後記 2011/08/31(Wed):[2011-08-31-1]の記事「LAEME text database のデータ点とテキスト規模」で,HelMapperUK で作製した地図の実例を示した.)

・ McIntosh, Angus, M. L. Samuels, and M. Benskin. A Linguistic Atlas of Late Mediaeval English. 4 vols. Aberdeen: Aberdeen UP, 1986.

・ Laing, Margaret and Roger Lass, eds. A Linguistic Atlas of Early Middle English, 1150--1325. http://www.lel.ed.ac.uk/ihd/laeme1/laeme1.html . Online. Edinburgh: U of Edinburgh, 2007.

・ Hotta, Ryuichi. The Development of the Nominal Plural Forms in Early Middle English. Hituzi Linguistics in English 10. Tokyo: Hituzi Syobo, 2009.

2011-05-16 Mon

■ #749. hel typist --- hellog 仕様の文字列変換 CGI [cgi][web_service][ipa]

本ブログでは,古英語,中英語,現代フランス語の引用や,IPA 「国際音標文字」などの発音記号を入力する機会が多いのだが,量が多いと,特殊文字や特殊記号の打ち込みが患わしくなってくる.この際だからと思い,ASCII文字だけで入力できる記法を定義し,それを目的の文字・記号へ変換するツールを作成してみた.英語史の周辺で用いることの多い文字・記号だけを変換の対象にしたので,名付けて hel typist.仕様,入力例,記法一覧はこちら.

基本的な使い方だけ簡単に解説する.a#d#eling, t#e_od, g#iue, Vous vous e^tes leve' tre`s to^t . などと入力すると æðeling, þēod, ȝiue, Vous vous êtes levé très tôt. などへ変換されるという単純な置換ツールで,ほとんどの特殊記法が「アルファベット1文字+句読記号1?2文字」で構成される.そこで使われている句読記号そのものを入力する場合には,スペース1文字を先行させることでエスケープする.

また,// // あるいは [[ ]] で囲まれた部分は特別に IPA mode として解釈され,IPA の発音記号用の記法が有効になる.主として現代英語の標準的な音素を表わす記号が,それぞれASCIIの1文字に対応しており,例えば "[[f@'nEtIks]]" と入力するだけで [fəˈnɛtɪks] が得られる.

記法はこれまで個人的に使っていたものが基礎となっているが,できる限り (1) 少ない打数で入力でき( þ などの HTML の実体参照より楽),(2) そのままでも何とか読める視認性を確保する(多少の暗記は必要だが t# で thorn とか,@ で schwa というのは容認可能と考える)記法を心がけた.

コンピュータでは,Unicode など文字の国際化が進んでいるとはいえ,いまだにウェブ上やメール上ではASCIIが優勢だし,ASCIIのテキストファイルのポータビリティの高さは変わっていない.数学の世界では,数式や特殊記号を (La)TeX によるASCII文字のみで表わす記法が広く用いられており,分野内でのコミュニケーションに貢献していると聞いている.言語学の世界でも,あるいはより限定的に英語史関連の世界でも,このような慣習がもっと発達すればよいなと思うのだが.

hel typist で定義されていない発音記号については,IPA入力ツールが便利.

[ 固定リンク | 印刷用ページ ]

2011-04-08 Fri

■ #711. Log-Likelihood Tester CGI, Ver. 2 [corpus][bnc][statistics][web_service][cgi][lltest]

以下に,汎用の Log-Likelihood Tester, Ver. 2 を公開.(後に説明するように,入力データのフォーマットに不備がある場合や,モードが適切に選択されていない場合にはサーバーでエラーが生じる可能性があるので注意.)

[2011-03-25-1]の記事で,コーパス研究でよく用いられる対数尤度検定 ( Log-Likelihood Test ) の計算機 Log-Likelihood Tester, Ver. 1 を公開した.Ver. 1 は,コーパスサイズを加味しながら2つのコーパスでのキーワード(群)の出現頻度を比べ,コーパス間の差が有意であるかどうかを検定するものだった.

Log-Likelihood Test は上述の目的で用いることが多いと思い,Ver. 1 ではあえて機能を特化させたのだが,より一般的に複数行,複数列の分割表で与えられるデータに対応する対数尤度検定を行ないたい場合もある.例えば,昨日の記事[2011-04-07-1]で,現代英語における though と although の出現傾向について BNC に基づいた調査を紹介したが,Text Domain ごとの頻度比率は,両語の間で統計的にどの程度一致している,あるいは一致していないとみなすことができるのだろうか.昨日のグラフから,although は学術散文に多く,though は創作散文に多いという傾向が一目瞭然だが,この直感的な「一目瞭然」は統計的にはどのように表現されるのだろうか.

このような場合には,次のような頻度表(値は100万語当たりの出現頻度に標準化済み)を準備し,これをコピーして入力ボックスに貼り付ける."lump mode" にチェックを入れ替え,"Go!" する.(デフォルトは "each-line mode" で,これは Ver. 1 と同等のモード.)

| though | although | |

|---|---|---|

| Natural and pure sciences | 56.3 | 80.13 |

| Applied science | 37.36 | 68.31 |

| World affairs | 45.81 | 68.2 |

| Social science | 48.98 | 63.38 |

| Commerce and finance | 46.18 | 57.21 |

| Arts | 74.07 | 52.93 |

| Leisure | 45.85 | 49.46 |

| Belief and thought | 70.78 | 46.75 |

| Imaginative prose | 80.2 | 26.37 |

結果は,1行だけの表として出力される.though と although を表わす2列の数値の並びが,統計的にどのくらい近似しているかを計算している.結論としては,両語の Text Domain ごとの頻度の並びの差は p < 0.0001 という非常に高いレベルで有意であり,両語の出現傾向は Text Domain によってほぼ確実に異なるといえる.

入力ボックスに入れるデータの書式は,タブ区切りの分割表.表頭と表側はいずれも省略可.サンプルのように表頭と表側の両方を含める場合には,左上のセルは空白にしておく必要あり.

"each-line mode" の機能は Ver. 1 と互換なので,入力形式もそちらの説明を参照.今回の Ver. 2 の "each-line mode" では,出力結果をシンプルにおさえてある(逆に,詳しい内部計算値を得たい場合には Ver. 1 のほうが有用).

Log-Likelihood Test の概要については,[2011-03-24-1]の記事を参照.

2011-04-05 Tue

■ #708. Frequency Sorter CGI [corpus][bnc][statistics][web_service][cgi][lexicology][plural]

何らかの基準で集めた英単語のリストを,一般的な頻度の順に並び替えたいことがある.例えば,[2011-03-22-1]で論じたように,頻度と不規則な振る舞いとの関係を調べたいときに,注目する語(群)の一般的な頻度を知る必要がある.この目的には,[2010-03-01-1]で紹介したような大規模な汎用コーパスに基づく頻度表が有用である.BNC lemma-pos list (122KB) や ANC word-tagset list (7.2MB) などで問題の語を一つひとつ検索し,頻度数や頻度順位を調べてゆけばよいが,語数が多い場合には面倒だ.そこで,上記2つの頻度表から,入力した語(群)の頻度と順位を取り出す CGI を作成した.

改行でもスペースでもカンマでもよいのだが,区切られた単語リストを以下のボックスに入力し,"Frequency Sort Go!" をクリックする.出力結果を頻度順位の高い順にソートする場合には,"sort by rank?" をオンにする(デフォルトでオン.オフにすると,入力順に出力される).例えば,現代標準英語に残る純粋に i-mutation を示す複数形は以下の7語のみである(複合語,二重複数,[2011-04-01-1]で話題にした sister(e)n は除く).これをコピーしてボックスに入力する.

foot, goose, louse, man, mouse, tooth, woman

まず,BNC lemma-pos list による出力だが,この頻度表は約1億語の BNC 全体から,頻度にして800回以上現われる,上位6318位までの見出し語 ( lemma ) を収録している.したがって,それよりも頻度の下回る goose, louse については空欄となっている.頻度と不規則性の相関関係を考える際に参考になるだろう.

次に,ANC word-tagset list による出力が続くが,この頻度表は BNC のものよりも規模が大きく,かつきめ細かい.合計22,164,985語を有する ANC (American National Corpus) から,Penn Treebank Tagset によってクラス付与された単位で語形が列挙されたリストである.タグセットが細かいので読みにくいし,自動タグ付与に起因するエラーも少なからず含まれているが,BNC のものよりも低頻度の語(形)を収録しているので,goose や louse の頻度情報も現われる.こちらの頻度表では WORD FORM ごとの頻度も確認できるため,直接 geese や lice の頻度も確かめられる.

当初 Frequency Sorter の用途として想定していたのは,上記の不規則複数形を示す語群などの頻度と順位の一括調査だったが,他にも用途はあるかもしれない.以下に,思いつきをメモ.

・ 1単語から使えるので,like のような多品詞語を入力して,品詞(あるいはタグ付与されたクラス)ごとの頻度を取り出せる.

・ ヒット数だけを確認したい場合には,いちいちコーパスを立ち上げる必要がない.

・ 論文やプレゼンで,ある目的で集めた数百語の単語リストの中から典型的な例,分かりやすい例を10個ほど示したいときなど,頻度の高い10個を選べばよい.例えば,[2011-03-29-1]で列挙した sur- を接頭辞にもつ単語リストのうち,例示に最もふさわしい10個を選ぶなどの目的に.頻度に基づいた順番のほうが,ランダム順やアルファベット順よりも親切なことが多いだろう(今後,本ブログ執筆に活用する予定).

・ 英米それぞれの代表的なコーパスに基づく頻度表を利用しているので,綴字や形態などの頻度の英米差を確認するのに使える.

・ (実際には lemmatisation が必要だが)適当な英文を放り込んでみて,妙に頻度の低い語が含まれていないかを調べる.頻度のツールなので,その他,教育・学習目的にいろいろと使えるかもしれない.

2011-03-25 Fri

■ #697. Log-Likelihood Tester CGI [corpus][bnc][statistics][web_service][cgi][lltest][sociolinguistics]

昨日の記事[2011-03-24-1]で Log-Likelihood Test を話題にした.計算には Rayson 氏の Log-likelihood calculator を利用すればよいと述べたが,実際の検定の際に作業をもう少し自動化したいと思ったので CGI を自作してみた.細かい不備はあると思うが,とりあえず公開.

上のテキストボックスに入力すべきデータは,タブ区切りの表の形式.1行目(省略可)はコーパス名,2行目以降はキーワードと観察頻度数(ヒット数),最終行は各コーパスのサイズ(語数)."#" で始まる行はコメント行として無視される.1列目のキーワード列は省略可.

以下のテキストが入力サンプル.[2010-09-11-1]の記事で取り上げたテレビ広告で頻用される形容詞(比較級と最上級を含む)トップ20の頻度を,BNCweb の話し言葉サブコーパスから話者の性別に整理した表である.このままコピーして入力ボックスに貼り付けると,出力結果が確認できる.

BNC_Male_Speakers BNC_Female_Speakers new 149 91 good 408 310 free 173 75 fresh 84 118 delicious 12 34 full 210 107 sure 532 328 clean 197 223 wonderful 270 258 special 177 82 crisp 10 16 fine 347 215 big 470 415 great 203 96 real 163 80 easy 326 157 bright 113 110 extra 347 203 safe 182 92 rich 120 45 #-------- corpus_size 4949938 3290569

男女間で有意差の特に大きいのは,対応行が赤で塗りつぶされた fresh, delicious, clean, wonderful, big で,いずれも期待度数に基づいて計算された Diff_Co ( "Difference Coefficient" 「差異係数」 ) がマイナスであることから,女性に特徴的な形容詞ということになる.big は意外な気がしたが,おもしろい結果である.一方,男性に偏って有意差を示すのは黄色で示した easy や rich である.この結果はいろいろと読み込むことができそうだし,より詳細に調べることもできる.広告の形容詞という観点からは,話者ではなく聞き手の性別,年齢,社会階級などを軸に調査してもおもしろそうだ.いろいろと応用できる.

2011-01-05 Wed

■ #618. OED の検索結果から語彙を初出世紀ごとに分類する CGI [lexicology][oed][cgi][web_service]

[2011-01-03-1], [2011-01-04-1]の記事で,OED 検索語彙を初出世紀ごとに分類して数え上げるという作業を行なった.よく考えてみると,このような作業はこれまでにも様々な調査・研究で繰り返し行なってきたことである.通時的語彙研究の基礎作業として今後も繰り返し行なう作業だと思われるので,OED の出力結果をもとに世紀ごとに数え上げるためのツールを作っておくことにした.名付けて "OED Century-by-Century Sorter".

以下は使用方法の説明だが,The Oxford English Dictionary. 2nd ed. CD-ROM. Version 3.1. Oxford: OUP, 2004. での作業を前提としている.ヴァージョンが異なると動かないかもしれないのであしからず.

(1) OED の ADVANCED SEARCH 等により,特定の条件に該当する語彙リストを出力させる.

(2) 下のテキストボックスに,(1) の検索に適当につけた簡便なタイトルを,ピリオド1文字の後に続けて入力する.例えば ".alchemy" .これが見出し行となる.

(3) テキストボックスで改行後に,(1) の出力結果を丸ごとコピーして貼り付ける.OED での出力結果が1画面に収まらない場合には次ページに進んで累積コピーし,テキストボックスに累積して貼り付けてゆく.年代順にソートされていなくても可.

(4) 続けて別の検索を行なう場合には (1), (2), (3) の作業を繰り返す.テキストボックスには,貼り付けたテキストが累積されてゆくことになる.

(5) Go をクリックすると,各検索結果について世紀ごとにカウントされた表が現われる.

説明するよりも実例を見るのが早いので,こちらのテキストファイルを用意した.これは,OED の ADVANCED SEARCH で "language names" にそれぞれ Japanese, Chinese, Malay, Korean, Vietnamese を入れて検索した結果の語彙リストを上記の仕様で納めたもの.これらの言語からの借用語数を世紀ごとに把握するのが狙いである.もっとも,OED の検索機能の限界で,それなりの数の雑音が結果リストに混じっているのでその点には注意.この(ような仕様に則った)テキストをコピーして,以下のテキストボックスに貼り付け,Go をクリックすれば表が出力される.

CGI スクリプトは大雑把な仕様なので,およその傾向を知るためのツールとして参考までに.特に以下の点に注意.

・ 初出年が "a1866", "c1629", "15..", "?c1400" などとなっている語はそれぞれ19, 17, 16, 14世紀へ振り分けられる

・ 初出年の記載のない語は一括して「0世紀」として振り分けられる

(後記 2011/04/24(Sun):OED Online の Timeline 表示では,初出世紀の頻度をグラフ化までしてくれるので,今回の CGI よりも使い勝手がよい.ただし,CD-ROM版の OED で作業するときや,設定に細かいチューニングが必要な場合のために自作した.)

2010-04-23 Fri

■ #361. 英語語源情報ぬきだしCGI(一括版) [etymology][dictionary][link][cgi][web_service]

[2010-04-03-1]の語源情報抜きだしCGIの改良版.情報源は同じ Online Etymology Dictionary.今回の「一括版」は複数の語の語源を一覧したいときに便利.1行1語で入力された単語リストを用意し,それを以下のテキストエリアに入れて Go するだけ.1語だけでも使えるので,事実上,前回の版の上位互換.語数が多いと時間がかかるし,サーバに負担がかかるので注意.

こうしてますます面倒くさがりになってゆく.

Powered by WinChalow1.0rc4 based on chalow